はじめに

こんにちは!早稲田大学大学院創造理工学研究科 修士1年の櫻井洸介です。私はCA Tech Jobとして、極予測LPでのインターンシップに1か月間参加し、今話題のDeepSeek-R1に画像認識機能を追加する研究に取り組みました。この記事では、私がこの期間取り組んだことについてご紹介します。

極予測LPとは

極予測LPとは、AIを活用しインターネット広告から遷移する先のページ(ランディングページ;LP)の制作を一新させる目的のプロダクトです。AIモデルによるランディングページの効果予測等を通じて、広告効果の最大化を目指しています。本プロダクトでは画像やテキストなどのマルチモーダルで複雑な情報を扱う必要があり、最先端のマルチモーダルAIの研究開発に積極的に取り組んでいます。

今回のインターンにおける取り組み

画像を認識しながら推論できるマルチモーダルLLMの構築

今回は、DeepSeek-R1-Distill-Qwen-1.5Bに画像認識能力を追加することにチャレンジしました。DeepSeek-R1と呼ばれる推論能力に強みを持つLLMが、画像も認識しつつ高度な推論ができれば、広告分野でも応用が期待できるのでは?と考え、このような問題に取り組みました。

広告分野における応用の可能性

広告分野においては、従来のMLLM(Multimodal Large Language Model)による広告画像認識は一定の性能を達成しています。例えば、製品画像の説明、ブランドロゴの認識やテキストの読み取りなどがあげられます。しかし、より複雑な広告画像の認識には推論能力が必要になります。

例えば、

- 隠喩的なデザイン:広告において、直接的に商品を見せずに視覚的な比喩や象徴を用いるケースがあります(例:「オレンジの断面」を使って時計の文字盤を表現するなど)。この場合、単純な画像認識ではなく、「何を意図しているのか?」を推測する能力が求められます。

- 文脈依存の理解:広告画像には、文化的背景や時事的な要素を取り入れたものも多く存在します。例えば、特定のキャラクターが特定のポーズを取ることで、流行中のミームを利用したマーケティングを行う場合、単にキャラクターを識別するだけではなく、その意図を読み取る必要があります。

- 広告戦略の一環としての推論:同じブランドでも、ターゲット層によって異なる広告戦略が取られます。たとえば、あるブランドが「高級感」を前面に出した広告と、「カジュアルさ」を押し出した広告を使い分けている場合、画像認識だけでなく「どの層向けの広告なのか?」を判断する推論が求められます。

こうした背景を考えると、推論能力の高いLLMが広告画像を認識できれば、より高度なマーケティング分析やクリエイティブ支援が可能になるのではないかと考えられます。

DeepSeek-R1とは?

みなさん、DeepSeek-R1[1]をご存じでしょうか。非常に低コストで開発されながら、OpenAI-o1 [2] に匹敵する性能を持ち、さらにオープンモデルとして利用可能なLLMとして注目を集めています。特に、強化学習(GRPO)によるアプローチから推論能力に強みを持ち、複数の数学タスクでOpenAI-o1を上回る性能を示しています。

一方、DeepSeek-R1の画像認識能力はどうでしょうか。試しに数学図形の問題をR1に入力してみます。

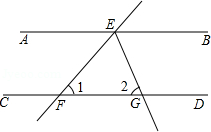

Q: ∠ACDは?(GeoQA [3] から引用)

“Parsing failed”というエラーメッセージと共に画像を入力することができませんでした。”Text extraction only”とのことで、どうやら図形問題のようなテキストを含まない画像は読み取ることができないようです。このような認識が不可能な画像に対しても、DeepSeek-R1を適用できるようにすることが今回の目標です。

DeepSeek-R1のVision方面への発展について

DeepSeek-R1を画像認識方面に発展させた研究についていくつか紹介します。DeepSeek-R1は、発表から約1ヶ月しか経っていないにも関わらず、すでにいくつかの画像認識分野への応用が検討されています。その大部分がR1で適用された強化学習アプローチ(GRPO)を、既存のオープンMLLM(Qwen2.5-VL [8] 等)の学習に利用した方法です [9, 10, 11]。GRPOを用いた学習により、通常のファインチューニング(SFT)と比べて特にOut-of-domainにおいて性能が向上したと示されています。他にも、OCR技術やText Parsing技術を用いてPDFや画像を高精度で読み取り、R1の入力として活用している手法 [12,13] も存在します。

一方、R1自体をLLMとして画像の認識に応用している手法は、現時点ではまだほとんどないように思います。これは、画像モデルと言語モデル(LLM; DeepSeek-R1)を接続するConnector(詳細は下記LLaVAの構造参照)を1から学習する必要があり、あらゆる画像の認識をするためには相応の学習データが必要だからだと考えます。本ブログでは、R-1をLLMとする新たなモデルを提案することで、推論能力の高い画像認識モデルの作成を目指します。

今回取り組む問題設定

今回は、DeepSeek-R1-Distill-Qwen-1.5Bの数学タスクに対する強みを活かすため、またデータの制約を考慮し、上図のような数学図形問題を解くことにしました。視覚的な情報を最大限活用し、複雑な論理的思考を重ねる必要がある数学図形問題を解くことで、視覚情報から論理的な推論を可能にする画像認識モデルの開発を目指します。

モデル構築の方法

本ブログでは、LLaVAと呼ばれるMLLMの基本的な構造を参考に、DeepSeek-R1に新たに画像特徴量を入力できるモデルを構築し、GeoQA [3] と呼ばれる幾何学的数学画像データセットで評価を行いました。具体的には、DeepSeek-R1-Distill-Qwen-1.5BとVision Encoder(SVE-Math)を統合し、Vision Encoderからの視覚情報をもとに画像の推論を行うVisual ReasoningタスクにR1を拡張します。以下にモデル構造と学習方法の詳細を記載します。

モデル構造

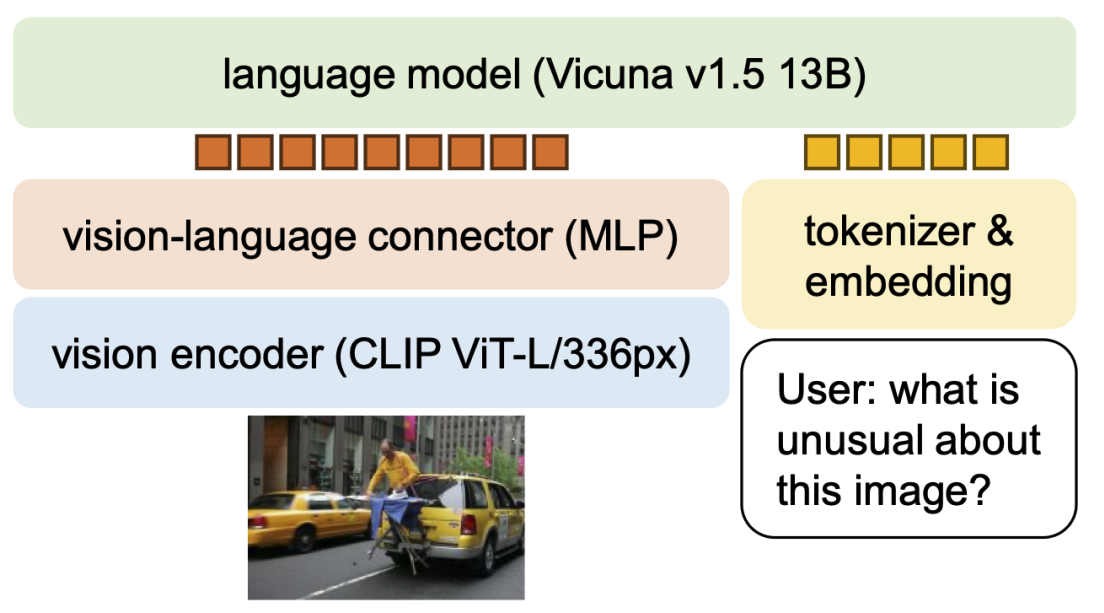

LLaVA [6] の構造

LLaVAはVision Encoderから出力される画像特徴量をLLMに入力することで、画像を理解した言語生成を可能にするモデルです。LLaVAは3つのモジュールから構成され、2つの事前学習済みモデル(Vision Encoder、LLM)をVision-Language Connectorで接続することで、画像特徴量をLLMが認識できる形に変換します。

提案手法では、LLMとして”DeepSeek-R1-Distill-Qwen-1.5B”を使用します。DeepSeek-R1は、Qwen2.5 [4] やLlama3 [5] といったオープンモデルへの知識蒸留を行い、バラメータ数1.5Bから70Bまでの小型LLMを作成、そしてそれら全てを一般公開しています。本ブログでは、Qwen2.5-Math-1.5B [4] をベースに知識蒸留し、最も軽量なモデルである”DeepSeek-R1-Distill-Qwen-1.5B”を使用しました。

また、Vision Encoderとして数学問題に特化したSVE-Math [7] を使用します。SVE-MathはGLIP [14] をベースに数学図形データで学習し、幾何学的要素(例えば、図形内の点や角度)を高精度で認識できるVision Encoderとなります。

最後に、Vision-Language ConnectorとしてMLP(2層のニューラルネットワーク)を使用します。Connector部分は1から学習されるため、汎用的な画像認識モデルの作成には通常相応のデータが必要ですが、本ブログでは数学問題に特化したVision Encoder(SVE-Math)を用いることで、比較的少量の学習データでR1のマルチモーダル化を目指します。

学習手法

学習ステップ

- stage 1:データセットGeo170k [15] やMathV360k [16] を用いて、Vision Encoderを事前学習(本実験では学習済みVision Encoder [7] を使用したため省略)

- stage 2:データセットGeo170k-alignment(数学図形とそのキャプションからなる約6万件のデータセット)を用いて、Connectorのみを学習

- stage 3:データセットGeo170k-QA(数学図形とそれに関する質疑応答からなる約11万件のデータセット)を用いて、ConnectorとLLMを学習

損失関数

- LLMの学習で用いられる損失(クロスエントロピー損失:今までの言語系列から、モデルが次に予測する単語(トークン)の確率を最大化する損失)

実験設定 – 幾何学的な画像を理解して推論できるか?

本実験では、GeoQAと呼ばれるデータセットでモデルの評価を行いました。GeoQAは、幾何学的な数学画像とそれに関する質問がプロンプトとして与えられ、回答を4つの選択肢の中から選ぶタスクです(データの詳細に関しては、前述の図形問題の画像、および後述のモデル出力例を参照ください)。このタスクを解くためには、幾何学的な画像の理解と論理的な推論能力が必要となります。プロンプトの冒頭に”First perform reasoning, then finally select the question from the choices in the following format: Answer: xxx.”というテキストを追加することで、LLMが思考しながら答えを導き出すこと、および回答フォーマットを統一することを促しています。

評価指標はAccuracy(正答率)としました。単純なアルゴリズムを用いて生成文から”Answer: ”の後に出力される選択肢を抽出し、それを真の値と比較することでモデルの性能を評価します。また、その他の学習設定はSVE-Math [7] に従いました。

Qwen2.5-Math-1.5B-InstructにVisionを付与できるか?

本ブログでは、DeepSeek-R1-Distill-Qwen-1.5Bに画像認識能力を追加する前に、R-1で蒸留する前のモデルであるQwen2.5-Math-1.5B-Instructに視覚情報を付与できるのかについて実験を行いました。具体的には、SVE-MathをVision Encoder、Qwen2.5-Math-1.5B-InstructをLLMとして、上記の実験設定に従いモデル構築を行いました。その実験結果を表1に記載します。

表1 GeoQAによる実験結果(Qwen2.5-Math-1.5B-Instruct)

| Model | Accuracy(%) |

| Random Chance | 25.0 |

| Human (Text-Only) [3] | 63.0 |

| Human (Text-Diagram) [3] | 92.3 |

| GPT-4V [17] | 43.4 |

| GPT-4o [17] | 61.4 |

| Qwen2VL-2B-Instruct | 39.4 |

| Qwen2.5VL-3B-Instruct | 62.1 |

| G-LLaVA-7B [15] | 64.2 |

| SVE-Math-Qwen2.5-Math-1.5B-Instruct | 73.9 |

※ 引用付きモデルの精度は論文参照

参考までに、一部論文記載の精度を引用しています。表1上段は、ランダム選択(Random Chance)や人による回答(Human)の精度を示しています。人による回答は、国立大学受験者の中で成績上位1%の生徒10名による調査とのことです。また、表1中段は一般的なクローズドモデル(GPT-4V / 4o)やオープンモデル(QwenVL)、従来の数学特化モデル(G-LLaVA)の精度を示しています。表1下段は、Qwen2.5-Math-1.5B-InstructにVisionを付与したモデルの精度を示しています。表1より、SVE-Math-Qwen2.5-Math-1.5B-Instructの精度(73.9%)は、Human(Text-Diagram)に劣るものの一般的なクローズドモデル(GPT-4V / 4o)、オープンモデル(QwenVL)を上回っていることが分かります。このことから、Qwen2.5-Math-1.5B-Instructに関しては視覚情報を付与できたと言えそうです。

R1のような推論能力の高いモデルに視覚情報を与えることはできるか?

続いて、DeepSeek-R1-Distill-Qwen-1.5Bに視覚情報を付与できるのかについて実験を行いました。

表2 GeoQAによる実験結果(DeepSeek-R1-Distill-Qwen-1.5B)

| Model | Accuracy(%) |

| Human (Text-Diagram) [3] | 92.3 |

| GPT-4V [17] | 43.4 |

| GPT-4o [17] | 61.4 |

| Qwen2.5VL-3B-Instruct | 62.1 |

| SVE-Math-Qwen2.5-Math-1.5B-Instruct | 73.9 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B | 70.7 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-think | 70.2 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT | 61.0 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT+think | 71.6 |

| SVE-Math-DeepScaleR-1.5B-Preview-think | 71.9 |

※ 引用付きモデルの精度は論文参照

実験結果を表2に記載します。比較のため、一部表1と同様の従来手法を記載していますが、DeepSeek-R1-Distill-Qwen-1.5Bを用いた提案手法は表2下段に示しています。表2より、提案手法(SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B)は非常に高精度(70.7%)でありながら、SVE-Math-Qwen2.5-Math-1.5B-Instructと比較するとわずかに劣る結果となりました。DeepSeek-R1は従来のQwen2.5などのLLMと異なり、いきなり回答を返すのではなく推論時に思考過程を述べてから回答を生成します。学習データセットには、この思考過程の部分が含まれていないため、R1の強みである推論能力が十分に発揮されていない可能性が示唆されます。この問題への対処も含めて、その他複数の実験を行った結果を表2、下4行に示しています。詳細は後ほど記載します。

次に、本モデルの出力をいくつか事例を挙げて紹介します。図形(画像)と質問は以下の通りです。

問題

Q: First perform reasoning, then finally select the question from the choices in the following format: Answer: xxx. Question:As shown in the figure, AB parallel CD, straight line EF intersects AB at point E, intersects CD at point F, EG bisects angle BEF, and it intersects CD at point G, angle 1 = 50.0, then angle 2 is equal to () Choices: A:50° B:60° C:65° D:90° <日本語訳> Q: まず推論を行い、最後に以下のフォーマットで選択肢から答えを選択してください。回答: xxx. 質問:図に示すように、AB は CD と平行で、直線 EF は点 E で AB と交差し、点 F で CD と交差し、EG は角 BEF を二等分し、点 G で CD と交差します。角 1 = 50.0 なので、角 2 は () に等しくなります。 選択肢: A:50° B:60° C:65° D:90°

この質問に対する回答は以下の通りです。比較として、Qwen2.5VL-3B-Instructの回答も載せておきます。

回答

SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B(提案手法)

A: Question analysis: Since AB is parallel to CD, we have the following relationships: angle 1 + angle BEF = 180°, angle 1 = 50°, angle BEF = 130°. Also, since EG bisects angle BEF, we have angle BEG = 1/2 angle BEF = 65°. Therefore, angle 2 = angle BEG = 65°. Thus, option C is the correct answer. Answer:C <日本語訳> A: 質問分析: AB は CD に平行なので、次の関係が成り立ちます: 角度 1 + 角度 BEF = 180°、角度 1 = 50°、角度 BEF = 130°。また、EG は角度 BEF を二等分するので、 角度 BEG = 1/2 角度 BEF = 65° となります。したがって、角度 2 = 角度 BEG = 65° です。 したがって、オプション C が正解です。回答:C

Qwen2.5VL-3B-Instruct

A: since AB parallel CD, therefore,angle BEF=angle 1=50°. Since EG bisects angle BEF, therefore,angle BEG=frac {1}{2}angle BEF=25°. Therefore,angle 2=180°-angle BEG-angle 1=180°-25°-50°=105°. Therefore, option C is selected. Answer:C <日本語訳> A: AB は CD と平行なので、角度 BEF = 角度 1 = 50° です。 EG は角度 BEF を二等分するので、角度 BEG = 1/2 角度 BEF = 25° です。 したがって、角度 2 = 180° - 角度 BEG - 角度 1 = 180° - 25° - 50° = 105° です。 したがって、オプション C が選択されます。回答: C

いかがでしょうか。提案手法の生成文は、まるで人が書いたかのように正確です。特に、”angle 1”や”angle 2”のような、画像を正確に認識していないと分からない図形内の要素まで的確に理解し、それを計算に反映させています。一方、Qwen2.5VL-3B-Instructは答えこそ合っているものの、その導出部分は適当のように思います。角度 BEF = 角度 1 の時点で間違っていますし、計算結果が105°にも関わらず、C: 65°を正解としてしまっています。

他の事例も見てみましょう。

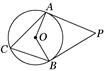

問題

Q: First perform reasoning, then finally select the question from the choices in the following format: Answer: xxx. Question:As shown in the figure, PA and PB are tangent to circle O at A and B respectively. If angle C = 65.0, then the degree of angle P is () Choices: A:65° B:130° C:50° D:100° <日本語訳> Q: まず推論を行い、最後に以下のフォーマットで選択肢から答えを選択してください。回答: xxx. 質問:図に示すように、PA と PB はそれぞれ A と B で円 O に接しています。 角度 C = 65.0 の場合、角度 P の角度は () です。 選択肢: A:65° B:130° C:50° D:100°

回答

SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B(提案手法)

A: Solution: Since PA and PB are tangents to the circle O, we have OA perpendicular AP and OB perpendicular BP. Hence, angle OAP = angle OBP = 90°. Also, we know that angle AOB = 2angle C = 130°. Therefore, angle P = 360° - (90° + 90° + 130°) = 50°. Thus, the answer is C. Answer:C <日本語訳> A: 解答: PA と PB は円 O に接しているので、OA は AP に垂直で、OB は BP に垂直です。 したがって、角 OAP = 角 OBP = 90° です。また、角 AOB = 2 角 C = 130° であることもわかっています。 したがって、角 P = 360° - (90° + 90° + 130°) = 50° です。したがって、答えは C です。回答:C

Qwen2.5VL-3B-Instruct

A: Solution: Since PA and PB are tangents to circle O at points A and B, we have OA perpendicular PA and OB perpendicular PB. Therefore, angle OAP = angle OBP = 90°. Also, since angle C = 65°, we have angle AOB = 130°. Thus, angle P = 50°. Therefore, the correct answer is C. Answer:C <日本語訳> A: 解答: PA と PB は点 A と点 B で円 O に接しているので、OA は PA に垂直で、OB は PB に垂直です。 したがって、角 OAP = 角 OBP = 90° です。また、角 C = 65° なので、角 AOB = 130° です。 したがって、角 P = 50° です。したがって、正解は C です。回答:C

この問題に関しても、導出部分を含めて適切に回答できています。質問文だけでは点Cの位置まで把握できないため、図形を認識し、その理解を言語生成に反映できていると言えるのではないでしょうか。

ここから、DeepSeek-R1の推論能力をより活かすため、追加で行った実験について詳細を記載します。DeepSeek-R1は、先ほど述べた通り推論時に思考過程を出力したのち回答を生成します。一方、提案モデルのstage 2、stage 3で使用したデータセットGeo170kには、回答までの導出部分こそ含まれているものの、R1のような長い(人間のような)思考過程は含まれていません。そのため、R1の強みである推論能力を十分に活かしきれていないと推察されます。そこで、学習データの作り方を工夫することで、よりR1の推論能力を向上させることを目指し、以下の実験を行いました。各提案モデルの説明と精度を以下にまとめます。

- SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B:数学特化Vision EncoderであるSVE-MathにR1を適用したモデル。学習データに思考過程(<think></think>で囲まれたテキスト)を含まず、通常のファインチューニング(SFT)により学習。

- SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-think:学習データの一部(導出部分)を<think></think>で囲み、擬似的に思考過程を模したデータで学習。

- SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT:LLaVA-CoT [18] で作成されたChain-of-Thought (CoT)*用データセット(LLaVA-CoT-GeoQA+)で学習。学習データ数は11,400件。

- SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT+think:学習前半はCoTデータセット、後半は通常のデータセット(Geo170k:<think></think>あり)で学習したモデル。

- SVE-Math-DeepScaleR-1.5B-Preview-think:DeepScaleR [19] をLLMとして、画像認識機能を追加したモデル。DeepScaleRはDeepSeek-R1をより数学問題に特化させたLLMであり、パラメータ数が1.5Bにも関わらずOpenAI-o1-previewを複数のデータセットで上回る性能を示したモデル。

*Chain-of-Thoughtとは・・・

LLMの出力の際、ただ答えだけを出力するのではなく「答えを導き出す思考ブロセス」も出力することで、人間のような論理的な思考のもと答えを導き出すアプローチ。

表3 GeoQAによる提案手法の実験結果(再掲)

| Model | Data | Accuracy(%) |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B | Geo170k | 70.7 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-think | Geo170k + <think></think> | 70.2 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT | LLaVA-CoT-GeoQA+ | 61.0 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT+think | LLaVA-CoT-GeoQA+ / Geo170k + <think></think> | 71.6 |

| SVE-Math-DeepScaleR-1.5B-Preview-think | Geo170k + <think></think> | 71.9 |

上記のような5つのモデルによる比較実験を行いました。驚くべきことに、学習データの思考過程を<think></think>で囲った場合(SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-think)、囲わなかった場合(SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B)と比べて精度がわずかに下回る結果となりました。単純に考えると思考プロセスを学習データに含めた方が精度は上がりそうですが、この実験からは真逆の結果となりました。このことから、DeepSeek-R1の学習に関しては適切な(R1の学習データと似たような)CoTデータセットで学習する必要があると言えます。

また、LLaVA-CoT [18] にて(GPT-4oを用いて)生成されたCoT用データセットによる学習(SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT)では、他の手法と比べて精度が10%ほど低下しました。これは、CoTデータセットのデータ数の少なさ、および(GPT-4oの生成による)データの不均衡性が要因であると考えます。一方、1エポック目をCoTデータ、2エポック目を通常のデータで学習した場合(SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT+think)は、2エポック全てを通常の学習データ(<think></think>あり)で学習した場合と比べて良い精度を示しました。1エポック目のデータ数が約1/10になっているにも関わらず精度が向上したことから、R1の学習において思考過程データの重要性が示唆されます。

最後に、LLMをDeepScaleRとした結果(SVE-Math-DeepScaleR-1.5B-Preview-think)に関して、同条件のDeepSeek-R1(SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-think)と比較して精度が1.7%向上しました。数学タスクに特化したい場合は有効だと言えそうです。

まとめた実験結果

表4 GeoQAによる実験結果 (全体)

| Model | Accuracy(%) |

| Random Chance | 25.0 |

| Human (Text-Only) [3] | 63.0 |

| Human (Text-Diagram) [3] | 92.3 |

| GPT-4V [17] | 43.4 |

| GPT-4o [17] | 61.4 |

| Qwen2VL-2B-Instruct | 39.4 |

| Qwen2.5VL-3B-Instruct | 62.1 |

| G-LLaVA-7B [15] | 64.2 |

| SVE-Math-Qwen2.5-Math-1.5B-Instruct | 73.9 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B | 70.7 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-think | 70.2 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT | 61.0 |

| SVE-Math-DeepSeek-R1-Distill-Qwen-1.5B-CoT+think | 71.6 |

| SVE-Math-DeepScaleR-1.5B-Preview-think | 71.9 |

※ 引用付きモデルの精度は論文参照

今後の課題

今回実装したモデルの今後の課題として、以下に3点ほど挙げたいと思います。まず、上記実験でも述べた通り、より良い学習データセットの検討が考えられます。本実験では、思考過程が少ないデータセット、もしくはデータ数が少ないCoTデータセットでしか実験することができませんでした。よりR1の推論能力を活かすためには、GPT-4oやR1などの既存のLLMを用いて、正確かつ一定量の推論データセットを用意する必要があると言えます。さらに、本実験におけるstage 2では、キャプション生成において思考過程を全く出力していません。stage 2も含めて、より良い学習のためのデータの検討が必要そうです。

2つ目に、MLLMの学習方法の検討が挙げられます。現状のモデルでは、クロスエントロピー損失を用いたSupervised Fine-Tuning (SFT)による学習を行っています。一方、DeepSeek-R1はGRPOと呼ばれる強化学習によるアプローチを取っています。実際、関連研究の章でも述べた通り、GRPOを用いて学習したMLLMの研究も現在盛んに行われており、学習データに含まれないOut-of-Domainに強いという研究成果からも、今後の方針の一つと言えそうです。

最後に、ビジネス応用への難しさも挙げたいと思います。本実験では、英語の図形問題を用いてR1を学習しました。一方、実ビジネスへ応用するとなると、精度はもちろんですが日本語への対応も非常に重要な要素となります。日本語へ適用するとなると、日本語データセットの作成や日本語基盤モデルの利用など、まだまだたくさんの障壁があるように感じます。ただ、DeepSeek-R1の登場に伴い、OpenAI-o1などの最先端モデルに匹敵する大規模モデルもオープンモデルとして扱える時代になりました。これらの技術の進歩により、またその技術を応用して新たな日本語モデルを作成することにより、もしかしたら本技術をビジネスへ活用できる日もそう遠くないのかもしれません。

まとめ

今回のインターンシップでは、DeepSeek-R1に画像認識能力を追加する開発を行いました。具体的には、既存のオープンな画像認識モデルと組み合わせることで、DeepSeek-R1を数学図形問題へ応用し、さらにR-1の推論能力を活かすための複数のアブレーション実験を行いました。その結果、DeepSeek-R1に視覚情報を与えることに成功し、推論能力を活かすための新たな知見を得ることができました。

今後、広告画像ドメインで活用する際にも、本提案モデルの構造で視覚情報を与えることができそうです。一方、広告画像認識のための推論過程データセットをどう用意するか、どのように大規模データセットにするか等、上記で挙げたような課題が今後の障壁となりそうです。

本インターンシップを通じて、最新の手法をキャッチアップする経験やそれを新たなモデルへ応用すること、またより良いモデルを目指して試行錯誤することなど、新鮮で有意義な体験をすることができました。この貴重な経験を支えてくださった極予測LPの皆さん、そしてサポートをしてくださった全ての方々に、心から感謝申し上げます。ありがとうございました!

参考文献

[1] Guo, Daya, et al. “Deepseek-r1: Incentivizing reasoning capability in llms via reinforcement learning.” arXiv preprint arXiv:2501.12948 (2025).

[2] OpenAI. “Learning to reason with llms.” https://openai.com/index/learning-to-reason-with-llms/ (2024).

[3] Chen, Jiaqi, et al. “GeoQA: A geometric question answering benchmark towards multimodal numerical reasoning.” arXiv preprint arXiv:2105.14517 (2021).

[4] Yang, An, et al. “Qwen2. 5 technical report.” arXiv preprint arXiv:2412.15115 (2024).

[5] Dubey, Abhimanyu, et al. “The llama 3 herd of models.” arXiv preprint arXiv:2407.21783 (2024).

[6] Liu, Haotian, et al. “Improved baselines with visual instruction tuning.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024.

[7] Zhang, Shan, et al. “Open Eyes, Then Reason: Fine-grained Visual Mathematical Understanding in MLLMs.” arXiv preprint arXiv:2501.06430 (2025).

[8] Bai, Shuai, et al. “Qwen2. 5-VL Technical Report.” arXiv preprint arXiv:2502.13923 (2025).

[9] “Multimodal Open R1.” https://github.com/EvolvingLMMs-Lab/open-r1-multimodal (2025).

[10] Chen, Liang, et al. “R1-V: Reinforcing Super Generalization Ability in Vision Language Models with Less Than $3.” https://github.com/Deep-Agent/R1-V/tree/main?tab=readme-ov-file (2025).

[11] Shen, Haozhan, et al. “VLM-R1: A stable and generalizable R1-style Large Vision-Language Model.” https://github.com/om-ai-lab/VLM-R1 (2025).

[12] Fireworks AI. “DeepSeek R1 Just Got Eyes with Fireworks AI Document Inlining.” https://fireworks.ai/blog/deepseek-r1-got-eyes (2025).

[13] Steven. “Adding MultiModal Capabilities to Deepseek R1 using Dify.” https://dify.ai/blog/adding-multimodal-capabilities-to-deepseek-r1-using-dify (2025).

[14] Li, Liunian Harold, et al. “Grounded language-image pre-training.” Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2022.

[15] Gao, Jiahui, et al. “G-llava: Solving geometric problem with multi-modal large language model.” arXiv preprint arXiv:2312.11370 (2023).

[16] Shi, Wenhao, et al. “Math-llava: Bootstrapping mathematical reasoning for multimodal large language models.” arXiv preprint arXiv:2406.17294 (2024).

[17] Xu, Haotian, et al. “RedStar: Does Scaling Long-CoT Data Unlock Better Slow-Reasoning Systems?.” arXiv preprint arXiv:2501.11284 (2025).

[18] Xu, Guowei, et al. “Llava-o1: Let vision language models reason step-by-step.” arXiv preprint arXiv:2411.10440 (2024).

[19] Michael, Luo, et al. “DeepScaleR: Surpassing O1-Preview with a 1.5B Model by Scaling RL.” https://github.com/agentica-project/deepscaler (2025).