ABEMA ではサービスへの流入を促進するために SNS にスポーツの切り抜き動画やニュース記事を制作・配信しています。また、これらのコンテンツは速報性が重要であり、早ければ早いほどユーザーに見てもらいやすいという特性があります。そこでコンテンツ制作を効率化するために、クラウド上で映像編集できるシステムと動画の AI 解析基盤の開発を行っております。本セッションでは、これらの技術をどのように連携・活用しているか、またその中で拘った点や工夫したポイントを、具体的な事例を交えて紹介します。

本記事は、2025年03月21(金)に開催した「CA. ai#1」において発表された「ABEMA のコンテンツ制作を最適化! 生成 AI × クラウド映像編集システム」に対して、社内の生成AI議事録ツール「コエログ」を活用して書き起こし、登壇者本人が監修役として加筆修正しました。

株式会社AbemaTV Development Headquarters 機械学習エンジニア

加藤 諒

2022年新卒入社。機械学習エンジニアとしてAmebaブログに用いられる機械学習モデルの開発を経て、現在は「ABEMA」で動画解析基盤の開発や生成AIを活用したプロジェクトに従事。

このLTでは、ABEMAの中でどのように生成AIを活用しているかという事例についてお話しし、それに関連して使用しているツールの紹介もしていきたいと思います。

改めまして、加藤諒と申します。2022年にサイバーエージェントへ入社し、現在はABEMAで機械学習エンジニアとして働いています。よろしくお願いします。

最初に、ABEMAについて簡単にご紹介させてください。ABEMAは「新しい未来のテレビ」をコンセプトに展開している動画配信事業です。国内で唯一、24時間体制で編成されたニュース専門チャンネルを持っているほか、オリジナルドラマや恋愛番組、アニメ、スポーツなど、さまざまなジャンルの番組を24時間365日配信しています。

ABEMAはスマートフォン、テレビ、PCなどさまざまなデバイスに対応しており、いつでもどこでも、さまざまなシチュエーションで視聴できるようになっています。

早速本題に入っていきたいと思います。皆さんは日常的にSNSを利用されていますでしょうか。僕自身はかなり頻繁に活用しています。

ABEMAでは、配信しているコンテンツをより多くの人に届けるために、SNSやオウンドメディアを積極的に活用しています。SNSを通じて話題を広げたり、ABEMAが自社で運営しているメディアを活用することで、さまざまな人に向けてコンテンツを届けられるような取り組みを行っています。

具体的には、ABEMA内で配信されている動画コンテンツを編集したり、切り抜いたりして、ショート動画として再構成しています。また、その動画の内容を記事化してテキストとして起こし、SNSやオウンドメディアに投稿する活用をしています。こうした手法によって、動画コンテンツの価値を拡張しながら、より多くの視聴者に届けることを目指しています。

その中でも、最終的な目的は多くの人にABEMAのコンテンツを届けることにありますが、ジャンルによって特に重視される要素が異なります。たとえば、ニュースやスポーツのように時事性の高いコンテンツにおいては、情報の鮮度がそのままコンテンツの価値に直結します。そのため、できるだけ事象が発生してからすぐに届けるという「速報性」が非常に重要になってきます。

そういった背景を踏まえて、ABEMAにおけるコンテンツ制作、特に二次利用コンテンツの制作において、AIを活用した事例を今回は2つご紹介させていただきたいと思います。

まず一つ目の事例として、ニュース記事制作についてご紹介します。先ほども少し話に出ましたが、ABEMAでは「ABEMA TIMES」というニュースメディアを運営しています。

このメディアは、Yahoo! Newsなどの外部メディアにも配信されており、皆さんの中にはYahoo! Newsや、その投稿経由で記事にアクセスしている方もいるかもしれません。実はその中にABEMA TIMESが制作した記事が含まれていることもあります。

また、ABEMA TIMESの記事は、ABEMAの視聴ページと連携しており、視聴導線としての役割も担っています。

ABEMA TIMESに掲載される記事は、これまでどのように制作されていたかというと、従来のフローでは以下のような工程を踏んでいました。まず、番組が放送された後、その番組の内容を文字起こしする必要があります。この作業は、外部の制作会社に依頼して行っていました。外部パートナーが番組を文字起こしし、そのデータがABEMA側に返ってくるまでに、だいたい2〜3時間ほどかかります。

また、番組の放送が深夜帯であった場合には、文字起こしの納品が翌営業日になることもありました。こうしたスケジュールのズレも含めて、速報性を重視したいという我々の目的に対して、時間的な課題が生じていました。

文字起こしデータを受け取った後は、ABEMA内でその内容を確認しながら、編集担当者が記事を執筆します。これにもおおよそ30分程度の時間がかかります。ここまで終わって、ようやく記事を公開できる状態になります。

この一連の流れの中では、やり取りの工程も多く、どうしても時間がかかってしまう構造になっていました。なので、速報性を重視するには、より効率的な仕組みが必要だと考えています。

先ほどお話しした通り、ABEMAにとって速報性は非常に重要です。その中で課題として浮かび上がってきたのが、人的作業による遅延です。

記事制作の工程には、人の手が必要な作業が多く含まれており、それが全体のスピードに大きく影響してしまっています。特に文字起こしや記事執筆などのプロセスは、作業者の数やスケジュールに依存してしまうため、どうしても時間がかかってしまうという課題がありました。

この「人が多いよね」という部分が、速報性を追い求める上では大きなボトルネックになっていたというのが、まずひとつ大きなポイントです。

もうひとつの大きな課題が、コミュニケーションによる遅延です。

外部の制作会社さんとのやりとりにもコストがかかっていて、その中で発生するやりとりのラグや、依頼から納品までの往復の時間など、さまざまなポイントで遅延が発生しているというのが実情です。

では、こういった遅延をどうやって解決していくかが次のポイントになります。ここからは、実際に私たちがどのように生成AIを活用してこの課題に取り組んだのかについてお話ししていきます。

なるべく早くコンテンツを制作したいという思いから、ABEMAでは生成AIを活用した自動文字起こしや記事生成に取り組んでいます。

こうした生成AIの導入によって、記事制作のフローは大きく改善されます。

ABEMAの放送が終了してから、すぐに文字起こしを生成します。だいたいこれは、1時間の番組だと30分かからないぐらいでできます。話者分離もされています。その後に、生成した文字起こしをベースに記事を作って、だいたい今だと2〜3分で数百文字の記事が出てきます。

で、それを人が確認したり、あるいは修正が必要な部分があれば、そこを少し手直ししてから投稿するという流れになっています。

数時間かかっていた記事制作のフローが、生成AIを活用することで30分かからない程度で完了するようになりました。これにより、作業者は主に生成された記事の確認や、必要に応じた軽微な修正のみを行えばよいという形に効率化することができました。

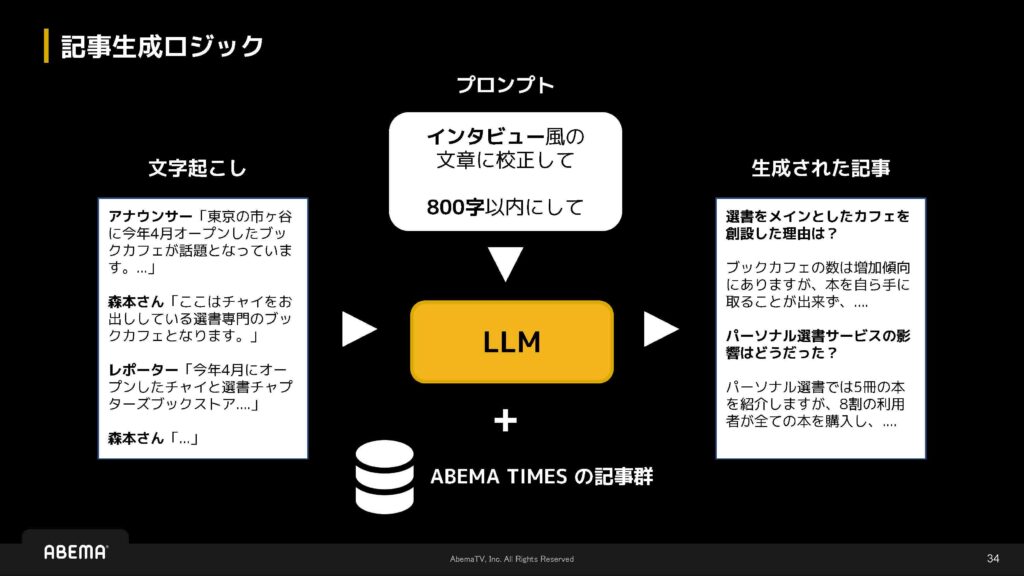

具体的な中身については、そこまで特別な工夫をしているわけではないのですが、基本的には文字起こしのデータを入力として使用し、プロンプトにインタビュー風やカジュアル風といった記事の雰囲気や、文字数の条件などを加えて生成を行っています。さらに、few-shot的なアプローチとして、ABEMA TIMESで過去に掲載された記事データをいくつか加えることで、文体や構成の参考にしながら記事を生成しています。

以前は、どのようなロジックやフローで運用しているかを中心にご説明しましたが、ここでは実際にどういった形で使っているのか、またどういった仕組みでそのシステムを実現しているのかについてお話しします。

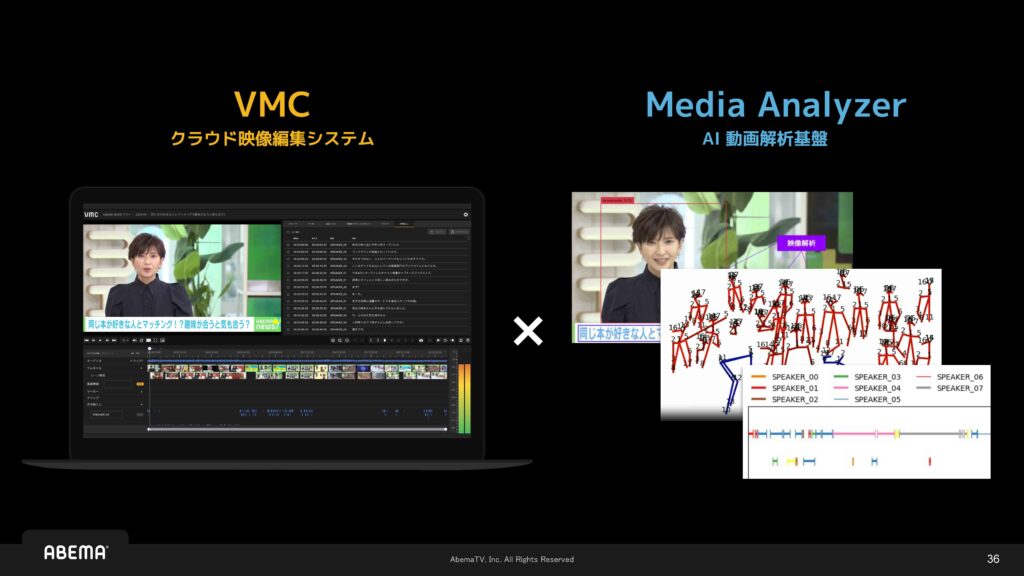

今回の発表タイトルにもありました通り、「クラウド映像編集システム」と「AI動画解析基盤」という2つの仕組みを組み合わせて、社内向けのツールとして開発を行っています。このツールは、実際にコンテンツ制作を担当するオペレーターの方々に利用していただいています。

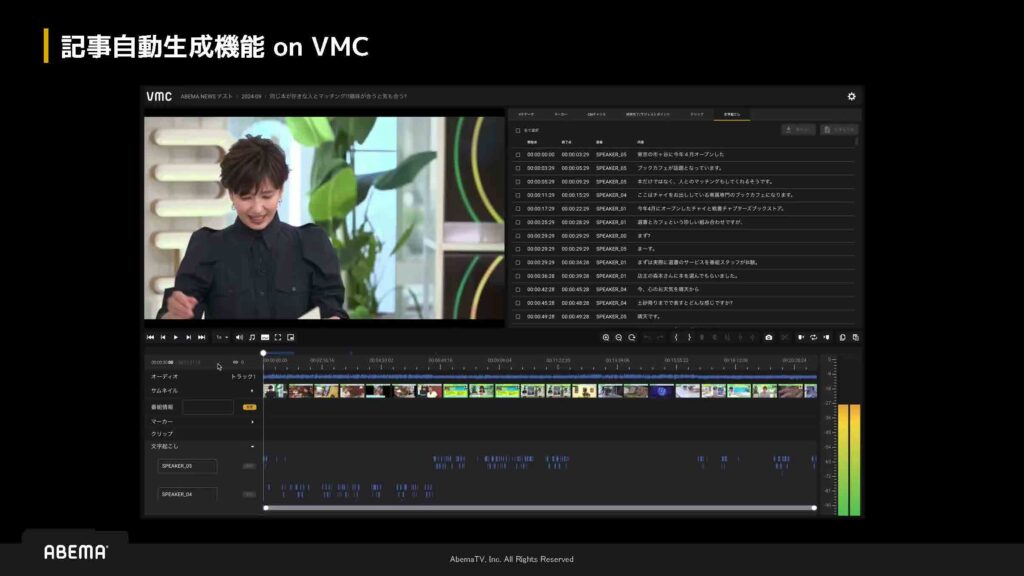

クラウド映像編集システムは「VMC」という名前のシステムで、ABEMAのビジネスプロセスに最適化されたブラウザベースのカスタムUIとなっています。操作性や導線なども、社内のオペレーションフローに沿う形で設計されており、業務の中で無理なく導入できるように工夫されています。

このシステムは、ABEMAのユースケースや業務上の要求に合わせて、完全に内製で開発しました。既存のツールでは対応しきれない細かなニーズにも対応できるよう、社内の実際の運用フローを踏まえた上で機能設計を行っています。

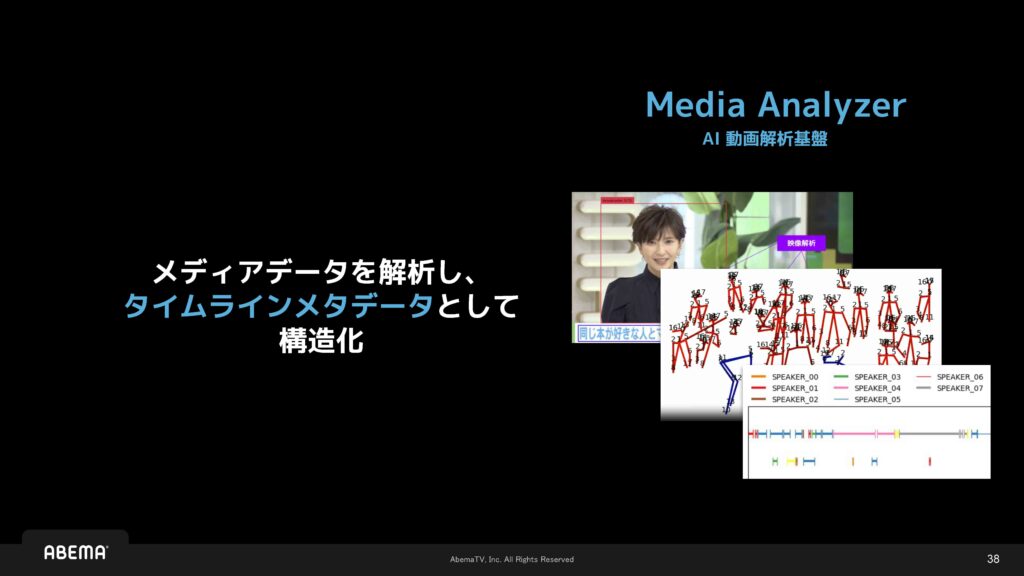

あとは、Media AnalyzerというAI動画解析基盤です。これは動画データを解析して、Timelineメタデータとして構造化できる仕組みを持っています。ここで言うTimelineメタデータというのは、時系列情報に文字起こしのテキストが紐づいている形式で、時間軸に沿ってテキスト情報が載っているものです。このように、動画コンテンツに時系列ベースで情報を付与することで、検索や編集を効率的に行えるようになります。

実際に記事の自動生成機能がどのように動作するかについては、動画でもご紹介していますが、ここでは実際のツールを使ってご説明したいと思います。

画面の構成としては、中央にプレビュー画面があり、右側には文字起こしのテキストが表示されています。また、下部にはTimelineがあり、誰がどのような発言をしているかが時系列で確認できるようになっています。現在選択されている部分は黄色くハイライトされており、この記事を生成したいという場面を選びます。

その後、記事のタイプを指定します。たとえばインタビュー風にするのか、どの登場人物にフォーカスするのか、文字数をどの程度にするか、使用するモデルをどれにするかなどの設定を行います。今回はClaude 3.5 Sonnetが指定されています。これらの条件をもとに生成を実行すると、テキストデータが返ってきます。

生成された記事は、そのままABEMA TIMESに投稿できるようになっており、制作フロー全体が非常にスムーズに進む設計となっています。

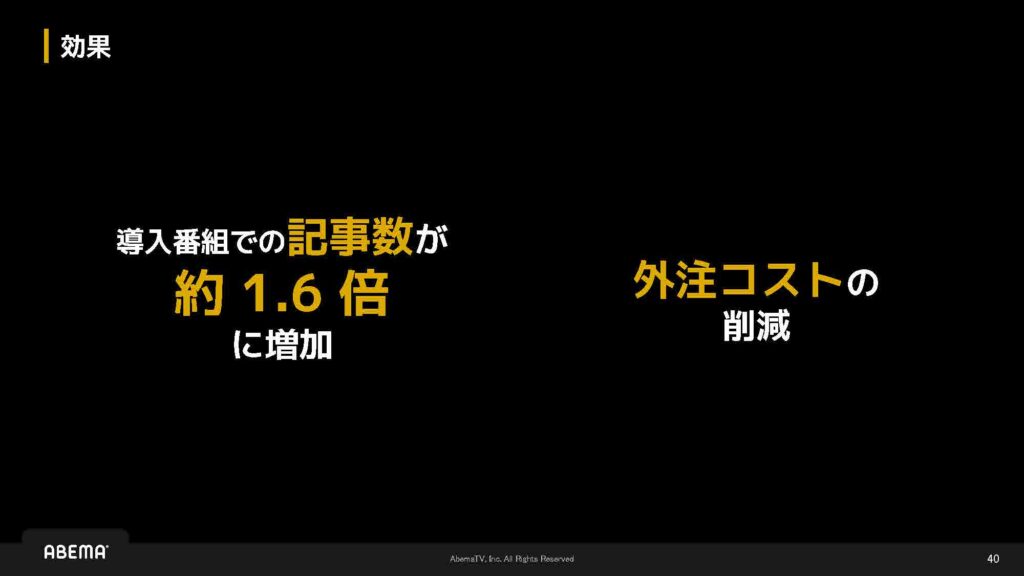

このツールを導入した番組では、記事の数が従来の1.6倍に増加するなど、実際の運用面でも大きな効果が見られました。また、外部への制作委託が減ったことで、外注コストの削減にもつながっています。

このニュース記事生成に関する詳細は、CyberAgengWayという社内メディアの記事にまとめられていますので、興味のある方はぜひご覧ください。

活用事例として、もう一つご紹介したいのが動画切り出しの制作です。

そういった領域にもAIの活用を進めており、今回はまだ実運用には至っていない段階ですが、その一部をご紹介させていただければと思います。

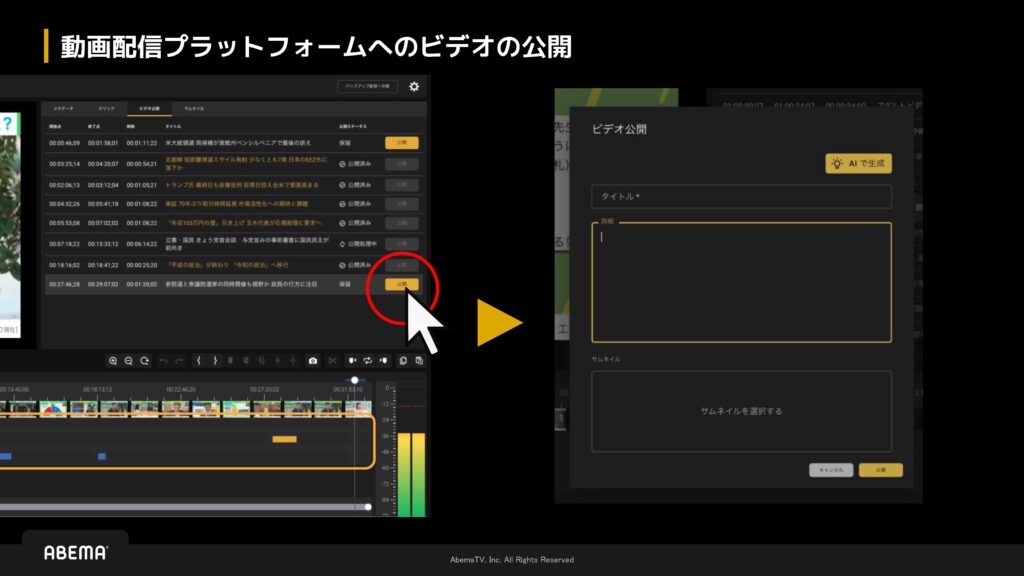

こちらはVMCの画面になります。ニュース番組を例に挙げると、1分程度の短いストレートニュースのように、トピックごとのニュースが連なって構成されており、それによって1時間の番組が成り立っています。それぞれのトピックを切り出し、個別のクリップとして扱うことができるようになっています。

画面内の赤丸で囲ってある部分、少し文字が小さくて見づらいかもしれませんが、そこに「公開」ボタンが設置されています。

「公開」と書かれたボタンを押すと、動画のタイトルや概要文、サムネイルを設定するための画面が表示されます。

そこで必要な情報を入力し、最終的にはその動画を配信プラットフォーム上に公開することができるようになっています。現在は、こういった一連の機能を開発中です。

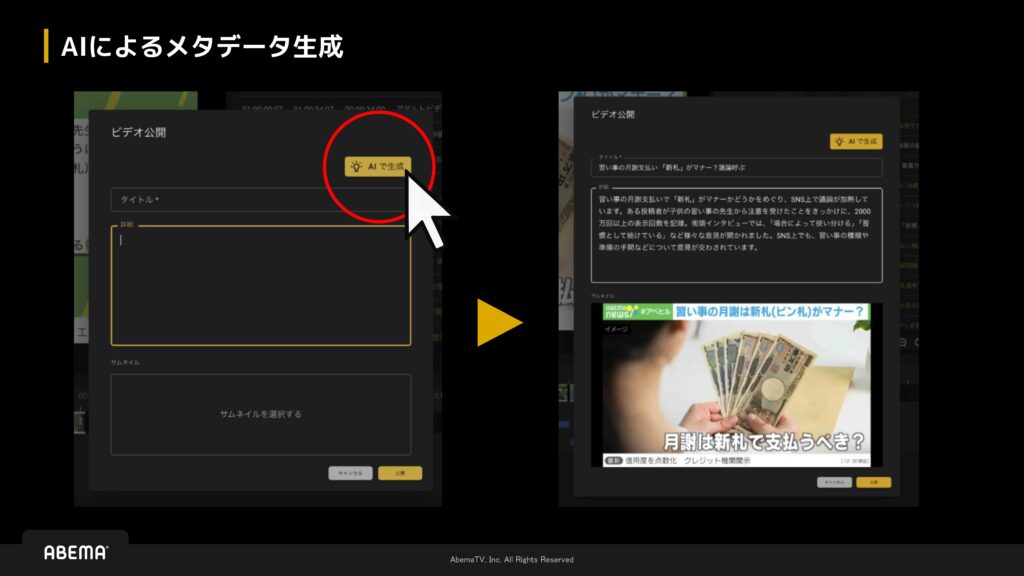

生成AIは、動画のメタデータに対しても活用しています。具体的には、タイトルや詳細文の生成に加えて、サムネイルについても、そのクリップの中から「それっぽい」最適なフレームを自動で選んでくれるような機能を備えています。最適という言い方には多少の曖昧さがあるかもしれませんが、視覚的に適したフレームをピックアップしてくれる仕組みになっています。

今ご紹介した2つの事例について、より技術的な観点から理解したいという方には、アーキテクチャやコードベースの解説を含んだ動画をおすすめしています。これらの詳細は「CyberAgent Developer Conference 2024」にて紹介しており、現在YouTubeでも公開中です。ご興味のある方は、ぜひそちらもご覧ください。

といったところで、今回のLTは以上となります。最後までご清聴いただき、ありがとうございました。