3月24日、サイバーエージェントのエンジニア・クリエイターによる技術カンファレンス「CyberAgent Developer Conference2022」を開催しました。本記事では「最新技術てんこ盛り!カムロ坂VisualProductionの撮影現場技術」の様子をお届けします。

目次

■VisualProductionとは

■カムロ坂スタジオやバーチャル撮影システムについて

■現場を安定/拡大させる取り組み:現場オペレーションの改善

■現場を安定/拡大させる取り組み:ライティングの簡易化

■VisualProductionとは

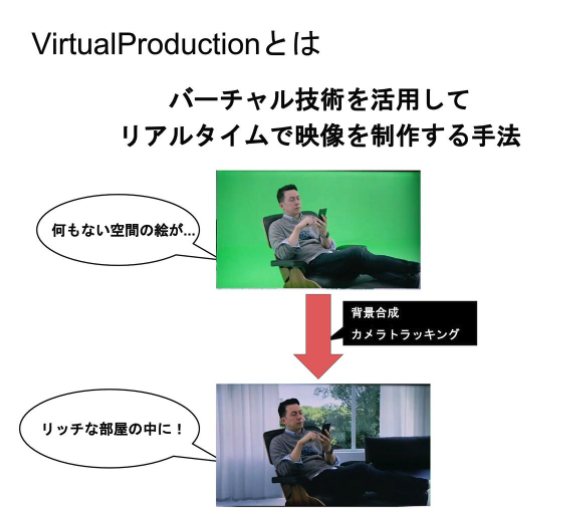

バーチャルプロダクションとはリアルタイムで映像を生成するプロダクションワークフローであり、CGやトラッキングなどバーチャルな技術が駆使されています。例えばこのように、クロマキーやLEDなど、何もない空間にCGで背景合成を行うことで非常にリッチな絵をリアルタイムで生成することが可能です。

これまでの撮影手法では、はじめに完成絵を想像し、撮影してからクロマキーをとり、CGのレンダリングを行なうなど、さまざまな作成フローを通じて合成絵を作ってきましたが、バーチャルプロダクションでは現場で合成まで行います。実際に最終絵を完パケとして使うかはさておき、7〜8割ぐらいの完成度で仕上げられます。

●広告クリエイティブの進化

サイバーエージェントがバーチャルプロダクションに挑戦する1番の理由は、広告クリエイティブに活用するためです。広告の世界はテクノロジーの進化によってより細分化され、素早さが求められるようになりました。広告クリエイティブの新しい作成方法を追求していく上で、バーチャルプロダクションの柔軟性やスピード感は非常に有益です。もうひとつは、コロナウイルス感染症拡大の影響も非常に大きなものです。あらゆるエンタメがオンライン化され、オンラインライブやコミュニケーションのあり方を新しく作るために、バーチャルプロダクションはこの1〜2年で急速に発展してきました。

■カムロ坂スタジオやバーチャル撮影システムについて

サイバーエージェントとCyberHuman Productionsが運営するカムロ坂スタジオや、バーチャル撮影システムについて紹介します。下記の動画は、年に1度開催されるエンジニアを対象とした表彰イベントのダイジェスト動画です。

会場となる巨大な空間には「いいね!」がたくさん飛び、背景のスライドにはさまざまな情報が表示されます。引きや寄りのさまざまなアングルが可能なほか、Zoomで中継をつないで受賞者のインタビューも生中継しました。

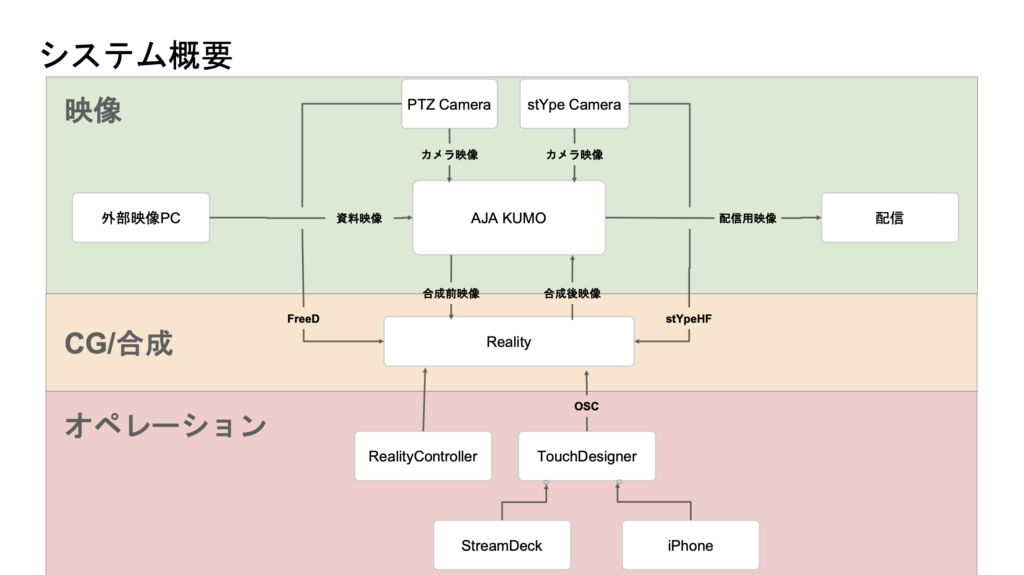

バーチャル撮影システムを概要図で説明します。カメラトラッキングはPTZカメラ、またstYpe社のredspyというトラッキング機材を搭載したARカメラも使っています。それらの映像をAJA KUMOという映像のハブに入れ、これらをRealityというシステムにてCGと合成しています。オペレーションはRealityControllerと、我々がTouchDesignerで独自開発したアプリで行います。

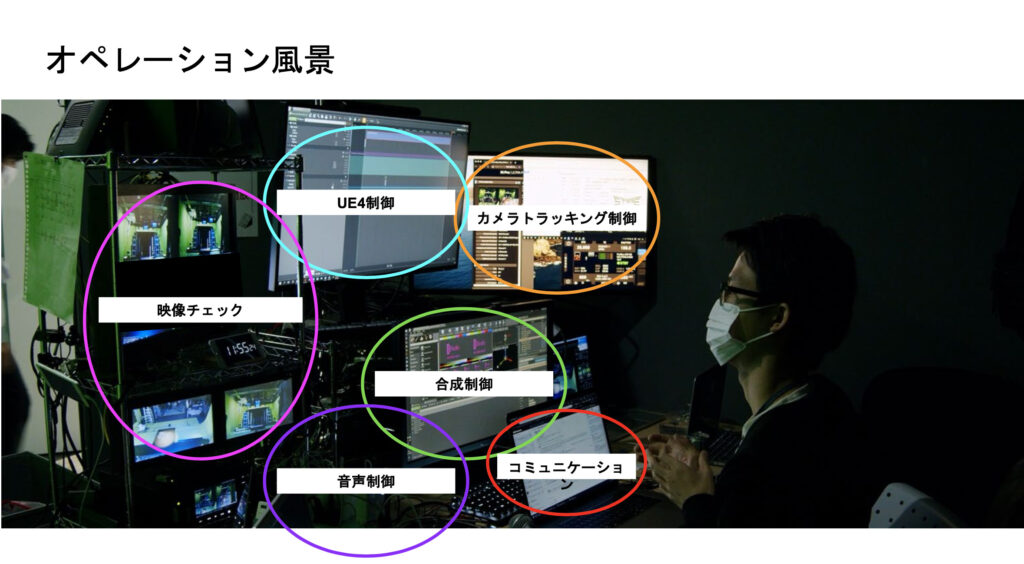

現場では1つの席から、あらゆるデバイスに対するオペレーションを可能としています。TeamViewerを用いることで、さまざまなアプリをPCから監視しております。

バーチャルプロダクションはCG、合成、カメラトラッキングなど多数の技術を複合するため、問題が起こっても、その判定が非常に難しくなります。しかし一気に監視することで、問題の特定が早くオペレーションできます。

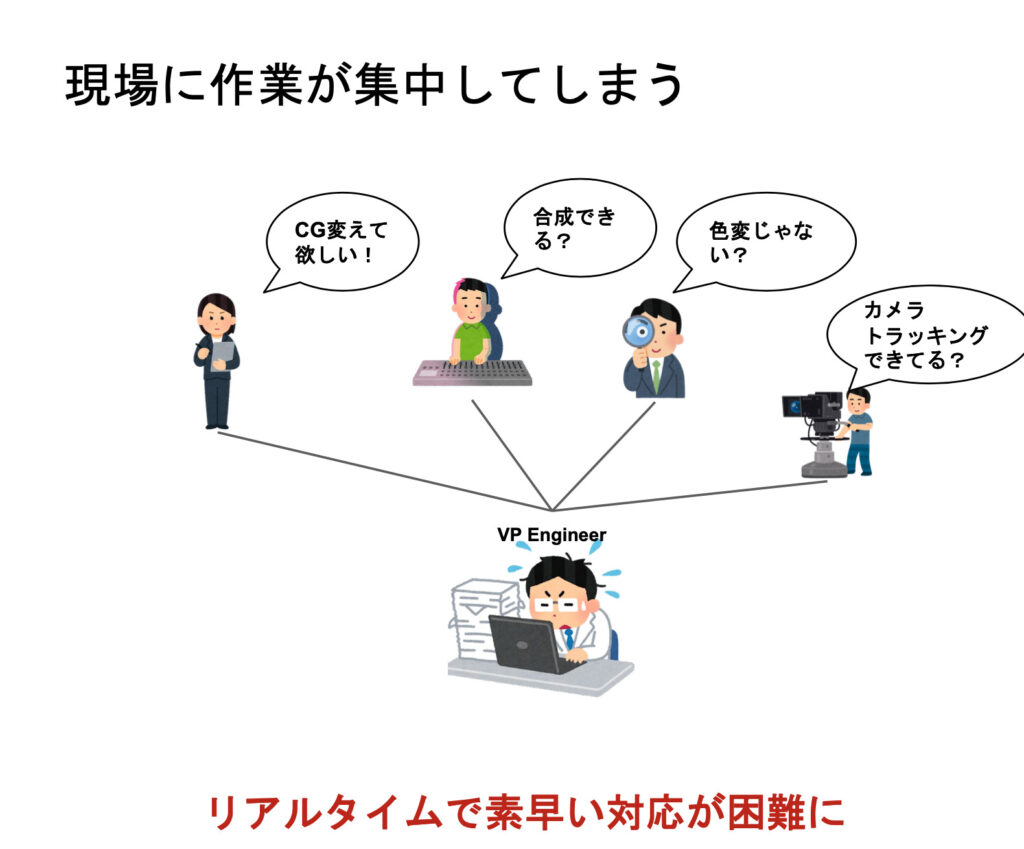

■現場を安定/拡大させる取り組み:現場オペレーションの改善

サイバーエージェントはこの1〜2年でバーチャルプロダクションを拡大し安定させてきました。始めた当初は、現場に作業が集中してしまうことが問題でした。リアルタイムに調整できるがゆえ「CGを変えてほしい」「色を変えたい」などの要望が頻出し、現場がパンクしがちだったのです。

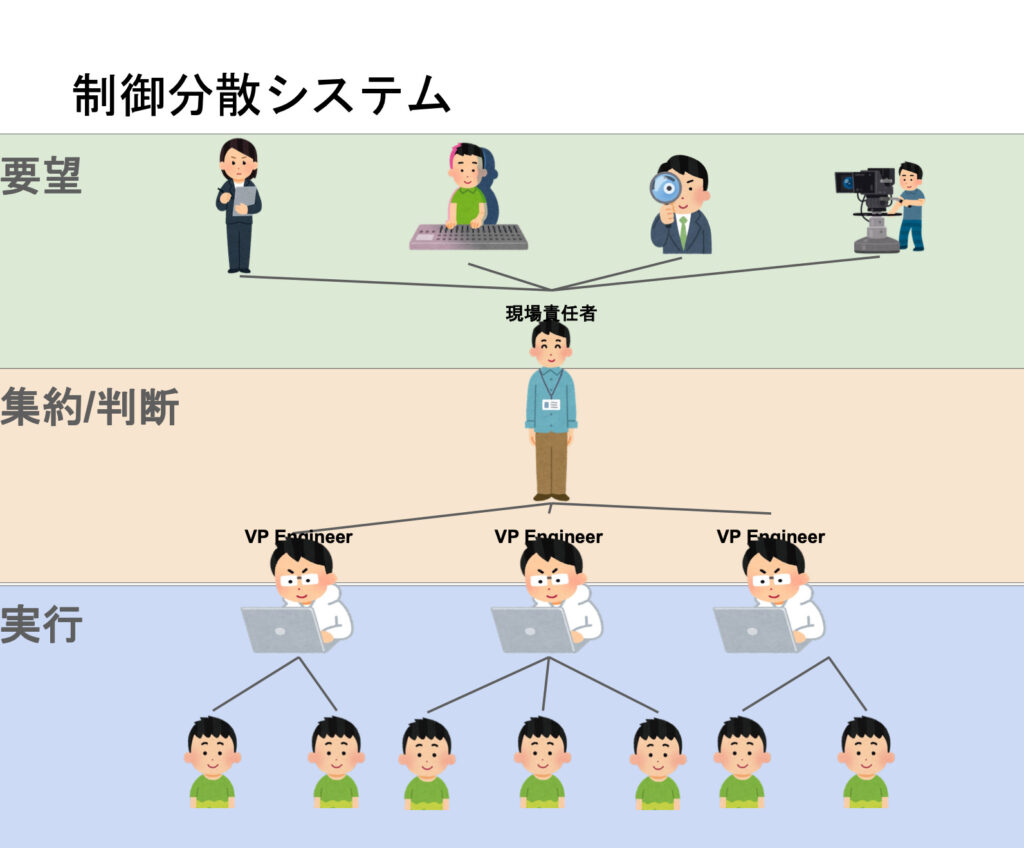

●制御分散システム

一日に対応できる量には限界があります。限られた時間で多くの要望に応えるために、非常に役に立つのがRealityControllerに含まれるRealityNodeです。これはUE4、Realityで動いているプロジェクトに対して、ノードベースのGUIで合成やCGの調整、カラーコレクションなど、あらゆる制御やロジックを組むことができます。このソフトはリアルタイムの制御を可能とし、プロジェクトを動作させているPCと同ネットワークであれば、複数のPC、複数人で同時制御できます。

もう一つ、RealityControllerにはRealityActionがあります。これはボタン式でリアルタイム制御が可能になります。オンかオフしかないので、RealityNodeだと制御が難しい人にはRealityActionでオペレーションをお願いしています。これまで一つ一つの作業が終わるまで次の作業に進めなかったのが、分業できることで、複数の問題に同時に対応しつつ素早く問題を解決できるようになりました。

しかしまだ問題がありました。Realityを導入したのは、実はサイバーエージェントが国内で初めてでした。日本で操作方法を習得したのは私が4人目。使える人が非常に少なく、現場に広げられないことが大きな課題でした。

●制御簡略化

操作を簡略化するためにOSC Hubを作りました。TouchDesignerをハブとして、さまざまなハードウェアからの入力をOSC経由で別のソフトやハードウェアへ飛ばします。Reality未対応の機材やソフトウェア、取り扱いが難しい照明などのハードウェアも独自ソフトでオペレーションが簡略化でき、誰でもオペレーションがしやすくなりました。もちろん並列制御にも対応しています。

もう一つBG Key Watcher(バックグラウンドキーウォッチャー)も作りました。キーボード入力がフォアグラウンドのアプリケーションにしかできなかったため、バックグラウンドにもキー入力できるようにしました。このアプリ開発は、Windows 32 APIを使用し、UIはC# Formsアプリで作成しています。

動作サンプルではStreamDeckアプリで、奥の照明と、CGを夜から昼への切り替えを同時にしています。これまでCGと照明の同時切り替えはできませんでしたが、OSC Hubでソフトとハードの同時作用が可能となりました。なおこのStreamDeckは配信の現場でスイッチャーさんが愛用している機材です。この機材でオペレーションを簡略化したことで、外部の方でも現場のオペレーションが可能となりました。このように、初めての方や慣れない方にも、実行部分を任せられるようになることで、バーチャルプロダクションエンジニアは集約や判断に注力し、より大規模イベントに対応できるようになりました。

次に、CG映像とLEDライティング技術を組み合わせて創りだす、高精細なCG背景空間で撮影が可能なLED STUDIOを紹介します。カムロ坂にはリアルタイムのクロマキー合成システムだけではなく、巨大なLEDを撮影するバーチャルプロダクションシステムもあります。LEDは5メートル×3メートル程度、解像度6K程度です。ここでカメラを動かして撮影しています。

●CG連動

このLED STUDIOでは、CGのレンダリングはUnreal Engine 4を使い、LEDの同期にはnDisplayというUEにある機能を使っています。カメラのトラッキングはクロマキー合成でご紹介したRedSpyというARトラッキングカメラを使い、トラッキング情報をCG内のカメラと同期させています。

■現場を安定/拡大させる取り組み:ライティングの簡易化

●CGに色を合わせるシステム

現場を安定・拡大させる取り組みとしてもう一つ、ライティングの簡易化にも取り組んできました。例えば太陽が昇ると同時に、周りの照明を変化させます。これは従来のようにシーケンスを組むのではなく、CGに連動して自動で照明が切り替わります。CGに色を合わせるシステムはいくつか開発しており、そのうちの一つをご紹介します。

これはUnreal EngineにあるDMXプラグインのピクセルマッピングという機能を活用しています。

CG空間内の色や明るさを照明信号に変換し、さらに現実世界の照明とArt-Netによって同期させることでCGとリアル世界が同期してより馴染んだ空間を実現しています。

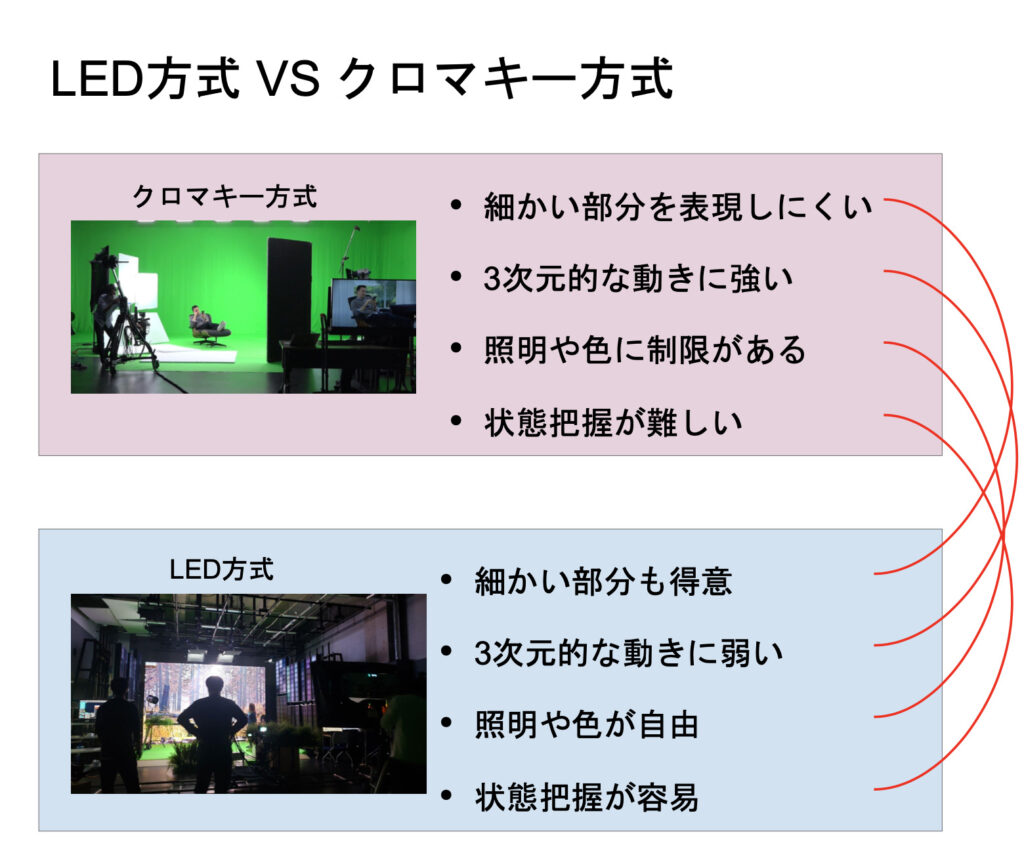

●クロマキー方式とLED方式

クロマキー方式とLED方式、2種類のバーチャルプロダクションについて比較します。クロマキー方式はクロマキーで抜くため、髪の毛の細かい部分などを表現できません。しかし緑を広げることで表現するエリアを広げられるので、三次元的な動きに強く、音楽ライブ案件などに適しています。

一方LED方式は細かい部分が得意で、髪の毛も非常にきれいに表現してくれます。しかしLEDを大きく広げるのは難しく、カメラアングルをダイナミックに使ったような三次元的な動きには課題が非常に多いです。またLEDはクロマキーのように色が落ちないので照明や色が自由な点も良さの1つです。

両者ともメリット・デメリットがありますが、カムロ坂スタジオのように、クロマキー方式とLED方式を使い分けたり、組み合わせることで、あらゆる場面に対応することが可能です。

●ボディーモーション

モーキャプシステムについて紹介します。こちらはモーションキャプチャーシステムを使用して作られたフルCGのバーチャルプロダクションの例です。こちらの制作ではバーチャルプロダクション現場で撮影した段階から多くの後編集が入っていまして、これまでのサンプルのように撮って出しではありません。

プリプロ映像を作る段階でバーチャルプロダクションが主に活用されまして、リアルタイムに「どういうアングルがいいだろう?どういうモーションがかっこいいだろう?」と試行錯誤することができ、非常に活躍しました。

撮影ではモーションキャプチャーのスーツMVNを利用しました。カメラトラッキングはOptiTrackを利用しています。実はモーションキャプチャー撮影とカメラトラッキングは別で、先にモーションキャプチャー撮影を終えてから、カメラトラッキングをしています。このカメラデバイスは自作で、スタジオの撮影用ショルダーリグにiPadの固定具をはめこみ、その上部に光学式マーカーをつけて位置をトラッキングできるようにしています。

UnrealEngine4はバーチャルプロダクション用のカメラにもサポートが用意されており、レンダリングされた映像をiPhoneやiPadなどのスマート機器にリアルタイムストリーミングして映像を見たり、ズームやフォーカスなどバーチャルカメラの設定を変えたりできます。

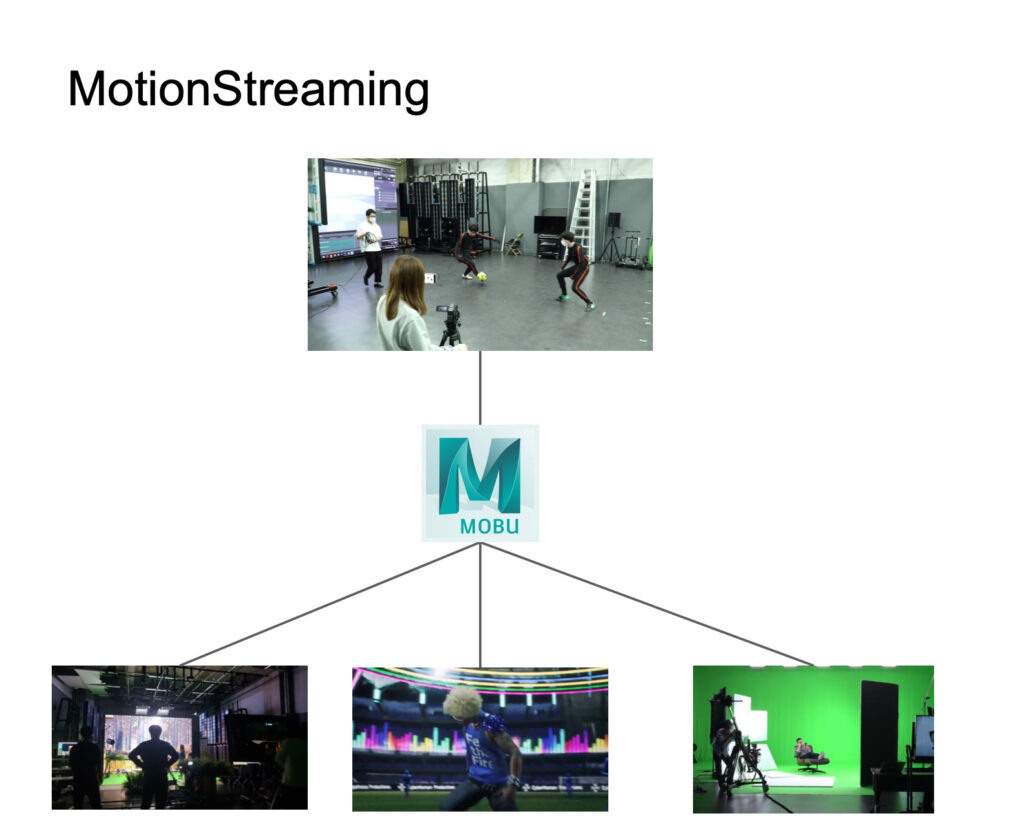

カメラのトラッキングやモーションのストリームはMotionBuilder経由で送りました。これを使う大きなメリットがリアルタイムの補正です。モーションに対してリーチの補正やリターゲティングを行うことで、リアルタイムでも、ある程度綺麗なモーションや動きを作ることができました。また、これまでに紹介したLED STUDIOやバーチャル撮影もUnrealEngine4をベースに作成されているため、これらのシステムにもモーションをストリームで送ることができます。

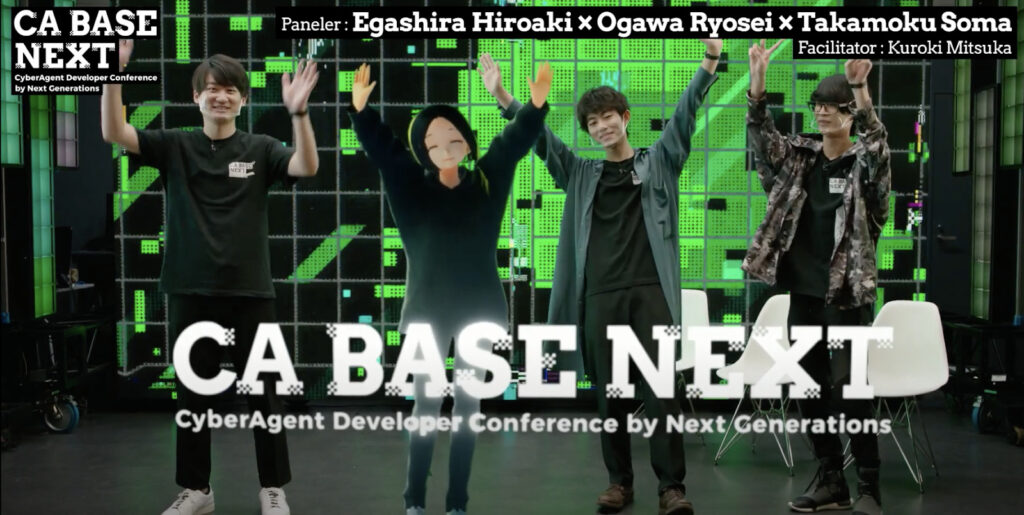

実際LED、モーションキャプチャー、バーチャル撮影の合成を組み合わせたものも作っています。下記は去年開催した若手エンジニアによるテックカンファレンス「CA BASE NEXT」のイチ講演の様子です。MVNでリアルタイムにモーションキャプチャーしているキャラクターをRealityという合成システムで合成し、背景にLED STUDIOを活用しています。

本来、ARでは背景にCGを出すのはレイヤーの問題で非常に難しいのですが、LEDを使うことで実現できています。前面はAR合成、背景はLEDでCGがリアルレイヤーを挟みこむことができており、CGキャラクターの存在感を非常に高めることができました。これらは全部常設の機材で実現しています。

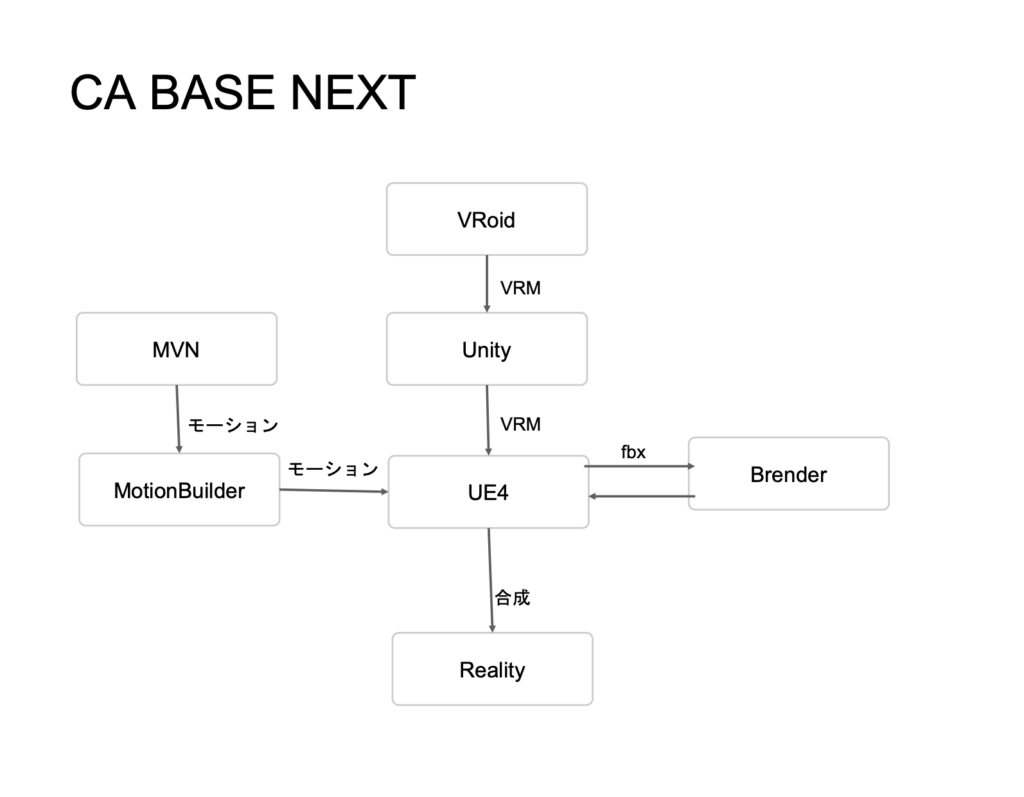

現場におけるモデルやモーションのフローはこの通りです。モデルはVRoidさんで、作成したモデルをUnityに持ち込みVRMとして調整、それをUnreal Engine 4に持ち込みましてRealityに合成します。モーションはMVNを使い、MotionBuilderで整形してそのモーションをUE4にライブリンクでストリーミング。モデル周りの調整などはBrenderを使いました。

現場で苦労したのは、セルルックのキャラクターを馴染ませることでした。フルCGだとどんどん可愛くなるようにセルルックに2D感を強めていけますが、現実世界と組み合わせるとどうしてもズレが生じます。そのズレが個性となるシーンもありますが、真面目なイベントでは、人となじませることが課題となり、かなり難航しました。

そこでPBRなシェーディングにして、光の影響を多く受けるようになじみを優先しました。それでも詰め切れない部分は、リアル側で青や緑など派手なライティングを施し、CG側も連動するようにして、派手なライティングで細かい所は気にならなくなるようにしました。

表情制御は現場でiPhoneを使いました。スマホから操作できるStreamDeckアプリから、キーボードで表情を変えています。単純ではありますが簡単で、誰でも制御できるようなインターフェースで現場の進行を進めることができました。

表情制御にはフェイシャルキャプチャーも検討しましたが、メリット・デメリットがあります。表現力が高いがゆえに、演者がプロの役者ではない場合、こうしたハードウェアが負担になるケースがありました。さらに当日の動きが予想できないため、トラブルに対応しやすいボタン式を採用しました。

まとめです。サイバーエージェントグループでは、さまざまなバーチャルプロダクションを運用することでノウハウを蓄積し、開発を進めてきました。今回紹介したのはごく一部で、この領域の技術は日々進化しています。バーチャルプロダクションの進化と安定運用には、オペレーションの分散と簡略化は非常に大事だと、この数年の挑戦の中で学びましたが、さまざまなハードウェア、ソフトウェアと人を一拠点に集めることで、弱点を補いあい、非常に強力なシナジーを得ています。

カムロ坂スタジオは、これからも最先端技術をいち早く取り入れ、どんなシーンの朱録にも対応できるようチャレンジを続けていきます。

AI事業本部 AICG事業/株式会社CyberHuman Productions/株式会社CyberMetaverse Productionsでは一緒にCG事業を盛り上げていただける方を大募集しています!

▼求人一覧

※正社員以外の働き方(副業・業務委託)も応相談。※大阪・京都での採用も行っています。

https://hrmos.co/pages/cyberagent-group/jobs/1694993421304987681

まずは情報交換をしたい、実際の仕事内容やチーム体制について、カジュアルに話を聞いてみたいという方は下記フォームよりお気軽にお申込み下さい。

カジュアル面談申込フォーム

https://bit.ly/3P7DoeB

「CyberAgent Developer Conference 2022」のアーカイブ動画・登壇資料は公式サイトにて公開しています。ぜひご覧ください。

https://cadc.cyberagent.co.jp/2022/

■採用情報

新卒採用:https://www.cyberagent.co.jp/careers/special/students/tech/?ver=2023-1.0.0