7月27・28日、サイバーエージェントの次世代技術者による技術カンファレンス「CA BASE NEXT 2022」を開催しました。本記事では「LEDwallを使ったVFXとColor Management」についてご紹介します。

本記事ではCGや映像撮影に興味がある初中級者を対象として、LEDwallを使った映像撮影とColor Managementについて紹介させて頂きます。

目次

■LEDwall活用事例の紹介

■In-Camera VFXの撮影フロー

■デジタルコンテンツと「色」

-色度図と色空間

-明るさとガンマ補正

■LEDwall Color Pipeline

-カラーマネジメント

-リニアワークフロー

■終わりに

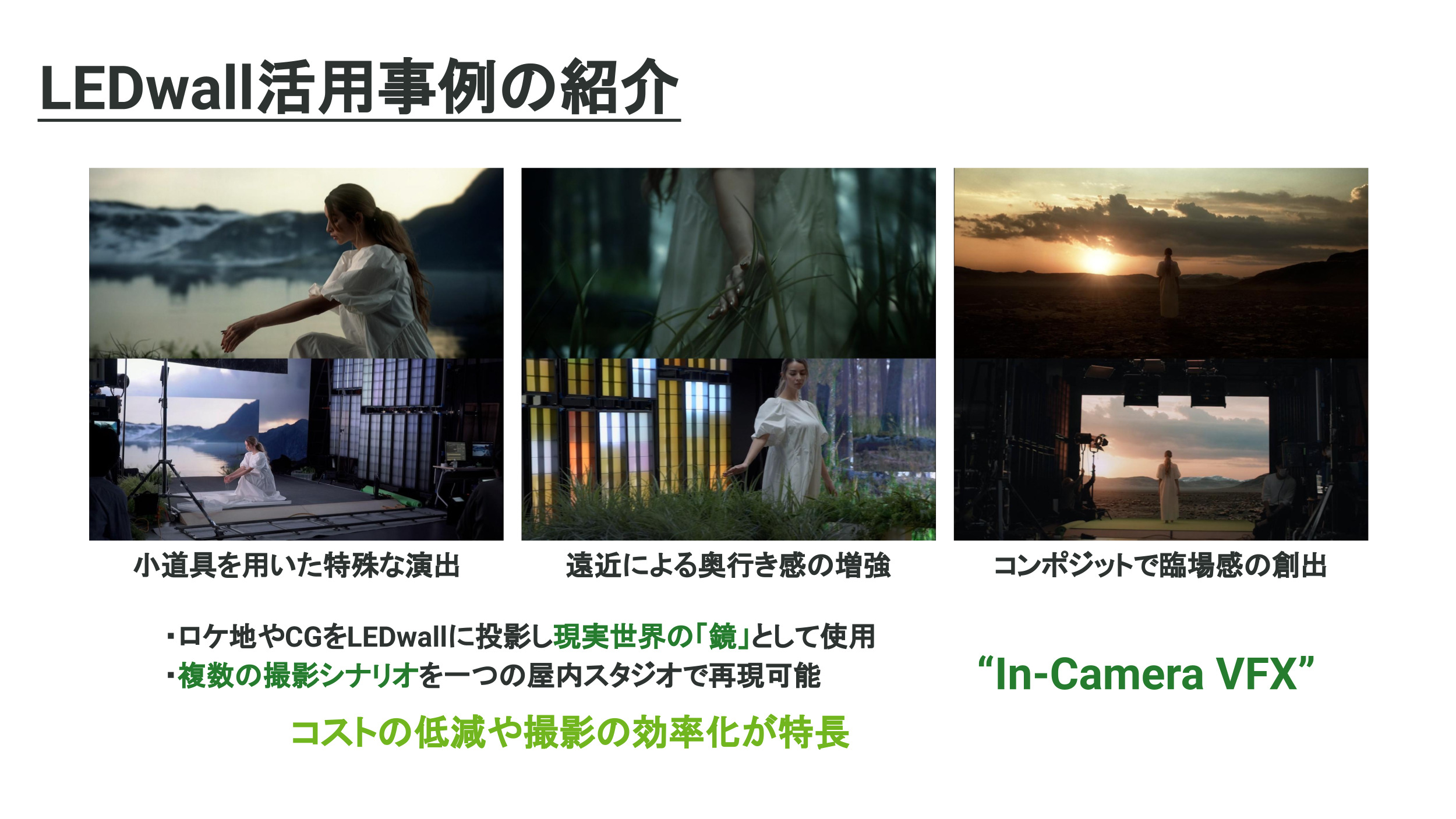

■LEDwall活用事例の紹介

この記事をご覧になっている方の中で、LEDwallというものをご存知の方はどれくらいいらっしゃるのでしょうか?

端的に申し上げれば、LEDwallとは現実世界の映像やCGで作った仮想空間を映し出すことのできる巨大なスクリーンになります。百聞は一見に如かず、という言葉もありますので是非こちらの動画をご覧頂ければイメージが付きやすいかと存じます。

Become a Dreamer

Become a Dreamer Behind the Scene

CyberHuman Productions LED STUDIOデモ

一本目の動画の中でもありましたように、LEDwallを使った撮影では様々な演出を取り入れることができます。動画の内容に則して代表的な例を挙げれば、

・水や風といった自然物や小道具を用いた特殊な演出

・草などのオブジェクトを前景に配置することで奥行き感の増強

・撮影後にCGとコンポジットすることで臨場感の創出

・etc…

等々、色々挙げることが出来ます。これらの特殊な演出方法はLEDwallならではのメリットにはなりますが、LEDwall最大の特長は、一つの屋内スタジオで様々なシーンの撮影が効率的かつ経済的に行えるということです。

動画内にあったような森林や砂漠、それから湖といった景観の大きく異なるシーンを実際に撮影しようとすると膨大な移動コストや時間がかかります。加えて、撮影時の天候にも状況が左右されてしまうでしょう。ところが、LEDwallを使った撮影ではこのような天候条件や撮影には直接的には関わらない移動に関わるコストを大幅に削減できるのです。

名称の紹介にはなってしまいますが、LEDwallに背景を投影してカメラで再撮影する手法を特に “In-Camera VFX” と呼びます。この言葉は、撮影Cameraを通してLEDwallに映し出された背景と前景の被写体を合成してVFX(=Visual Effects)を実現することに由来しております。第一章で述べた内容を下記の画像に簡単にまとめさせて頂きます。

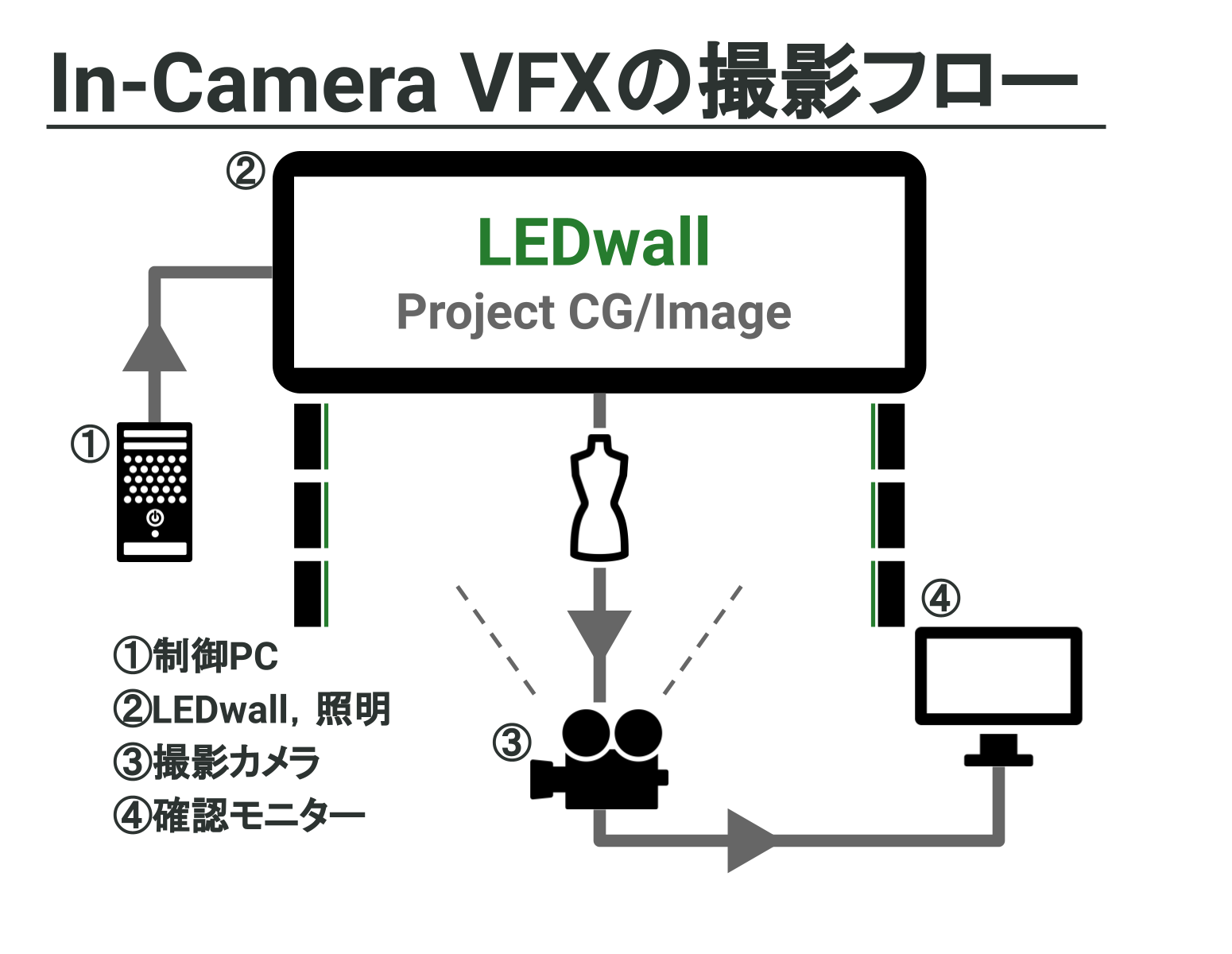

■In-Camera VFXの撮影フロー

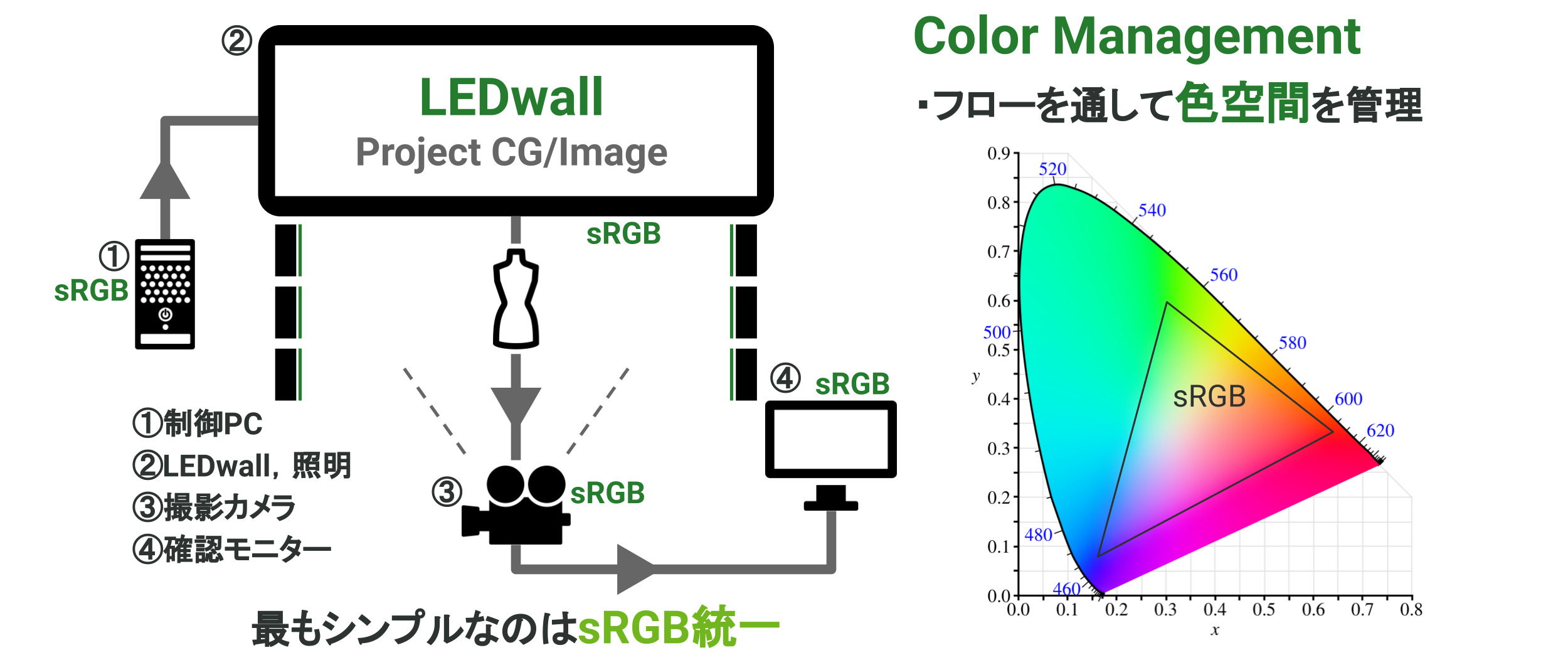

前章で紹介した In-Camera VFX という撮影方法ですが、基本的にはLEDwallに背景を映し出し、そして、LEDwallの手前側(前景)に被写体を置くことで撮影を行います。本撮影方法の映像や情報の流れを簡単にフローチャートにまとめると以下のようになり、大きく分けて4つのコンポーネントで構成されていることが分かります。

それぞれのコンポーネントは、

①制御PC:LEDwallの映像を制御

②LEDwall, 照明:背景や周辺光を再現

③撮影カメラ:実際に In-Camera VFX するカメラ

④確認モニタ:撮影データを確認するモニタ

というような役割を担っております。図からも解るように、被写体が情報として入り込んでくるのは②と③のプロセスの間ということになります。

このような撮影フローに従う In-Camera VFX ですが、前章で紹介したような長所だけではなく残念ながらIn-Camera VFX特有の難しさというものが存在します。以下に代表的な例としては、

・スタジオ全体で現実光を可能な限り再現(近似)する難しさ

・様々な入出力機器を媒介すること

・Digital-Analog-Digital(再撮影)の工程による弊害

といったことが挙げられます。以下で一つずつ詳細を解説させて頂きます。

一つ目の難しさは、LEDwallや追加の照明を使って現実のシーン(LEDwallに映し出している背景シーン)に合わせた照明環境を作り出さないといけない、ということです。例えば、LEDwallに砂漠のシーンを映し出したとして、それをただ闇雲に被写体と一緒に撮影したとしましょう。このようなケースでは、背景シーンと被写体が全く馴染まないのは火を見るよりも明らかです。何故なら、実際の砂漠では被写体に強い太陽光が当たっていたり地面からの照り返しがあったりするはずなので、その効果までをスタジオ内で再現してあげなければ被写体がその環境にいることを表現できないからです。この、背景と被写体の馴染み具合はIn-Camera VFX特有の難しさの一つと言えます。

二つ目の難しさは、パソコンやカメラ、モニターなどの様々な映像や規格を持った機器を媒介するので、予期せぬところで映像のテイストが変わってしまう恐れがある、ということに当たります。こちらに関しては「色度図と色空間」の節でも解説させて頂きますので、気になる方は記事を読み進んで頂ければ幸いです。

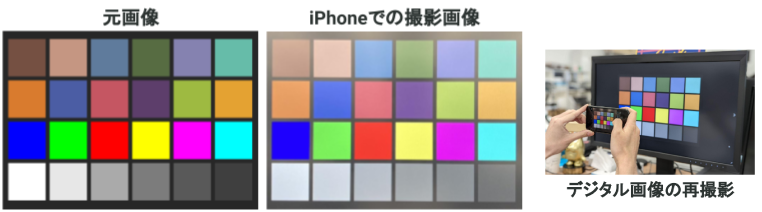

そして三つ目は、「背景映像(Digital)をLEDwallで出力し(Analog)、再びそれをカメラで撮影し映像(Digital)に戻す」という再撮影のプロセス自体に由来する難しさになります。こちらに関しては簡単に実験を行うことができますので、以下の画像を見て頂きたいです。

上記は、一番右の画像から見て取れますように、元画像(左)をモニターに出力し、それをiPhoneで再撮影した際の画像(中)を表しています。ここで注目して頂きたいのは再撮影画像に様々な問題があるところです。例えば、

・再撮影画像の色味が元画像と全く異なる点(e.g. 白が白、黒が黒じゃない)

・再撮影画像では外部光によって全体的に白っぽくなっている点(特に画像上部)

などが挙げられます。一つ目の問題は出力モニターやiPhoneカメラの色特性が、二つ目の問題は蛍光灯などの外部照明の光の映り込みが影響しております。個人用の小さなモニターでさえこういった再撮影による弊害が生じるので、これよりも何十倍も大きいLEDwallを使った場合ではより如実に問題が現れます。

本章で述べましたように、LEDwallを使ったIn-Camera VFXには強力なメリットと同時に、大きな撮影上の課題が存在していることが分かったかと思います。実際のスタジオでは、この弱点となる部分を解消または軽減することで、色味の変化や誤差を最小限に留めた実用レベルのワークフローを構築する必要があります。

したがって、以降の記事では実用的なワークフロー構築のために必要な技術的知識を中心に解説させて頂きますが、本題に入る前にまずは「そもそもデジタルコンテンツはデータ上どういう風に扱われているか?」という必要不可欠な知識のおさらいをしたいと思います。

■デジタルコンテンツと「色」

-色度図と色空間

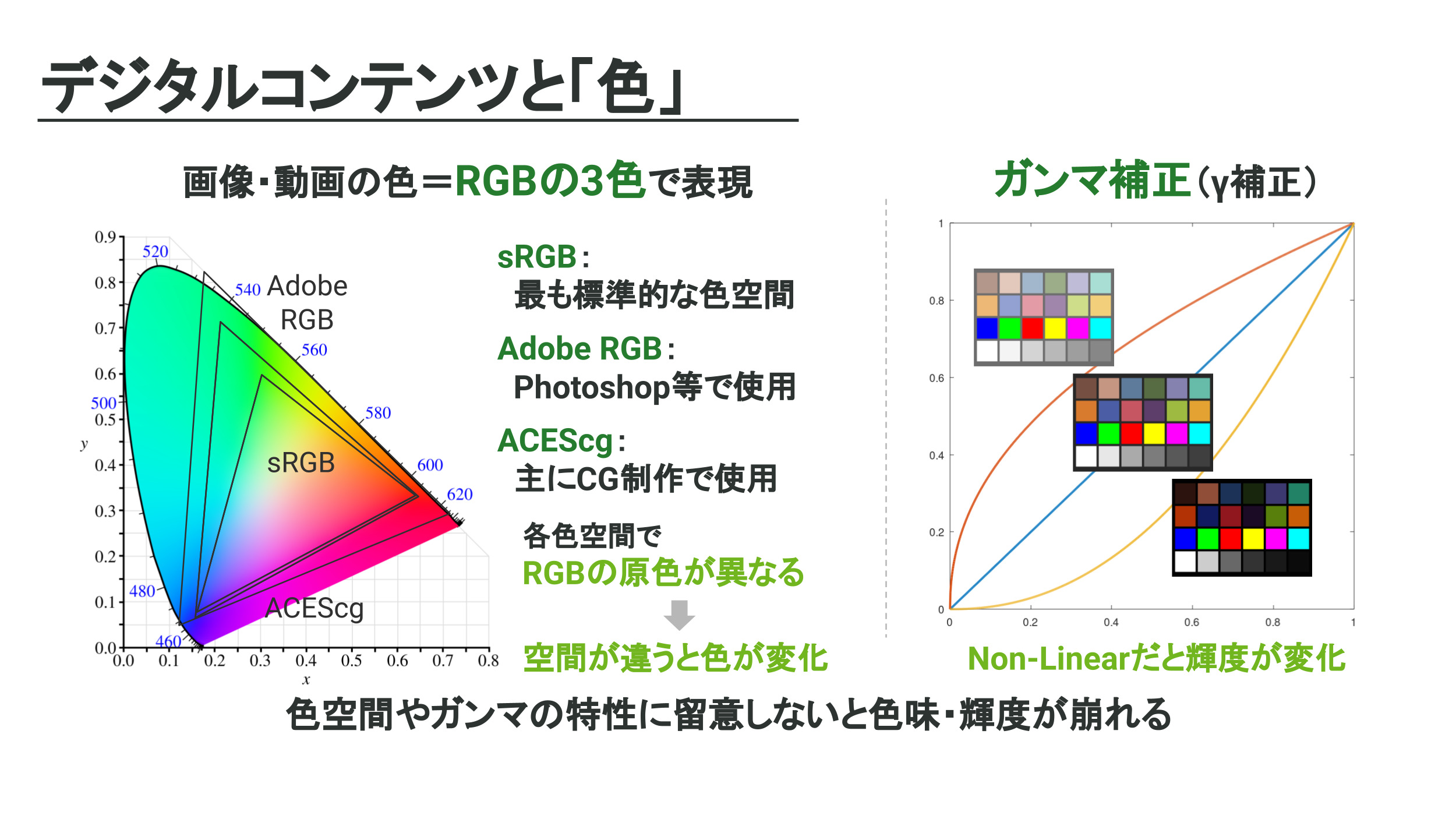

大部分の方々がご存知かとは思いますが、画像や動画などに代表されるデジタルコンテンツは Red-Green-Blue (RGB) の三色で表されることが主流です。このRGB表色系は人間の色認知の原理に由来している訳ですが、そもそも人間の知覚できる色とRGB表色系がどのように関係しているかを次に解説させて頂きます。

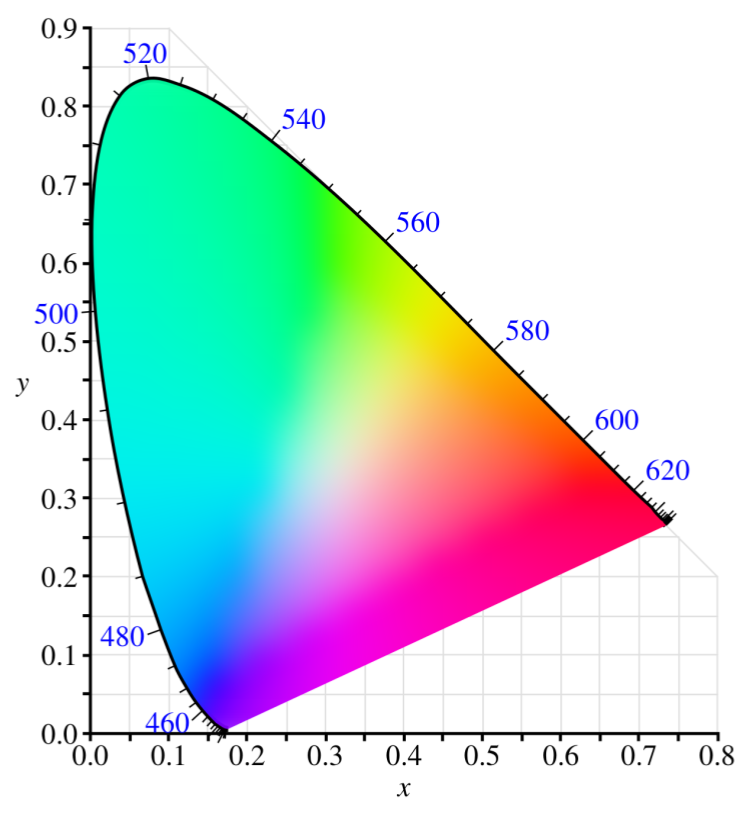

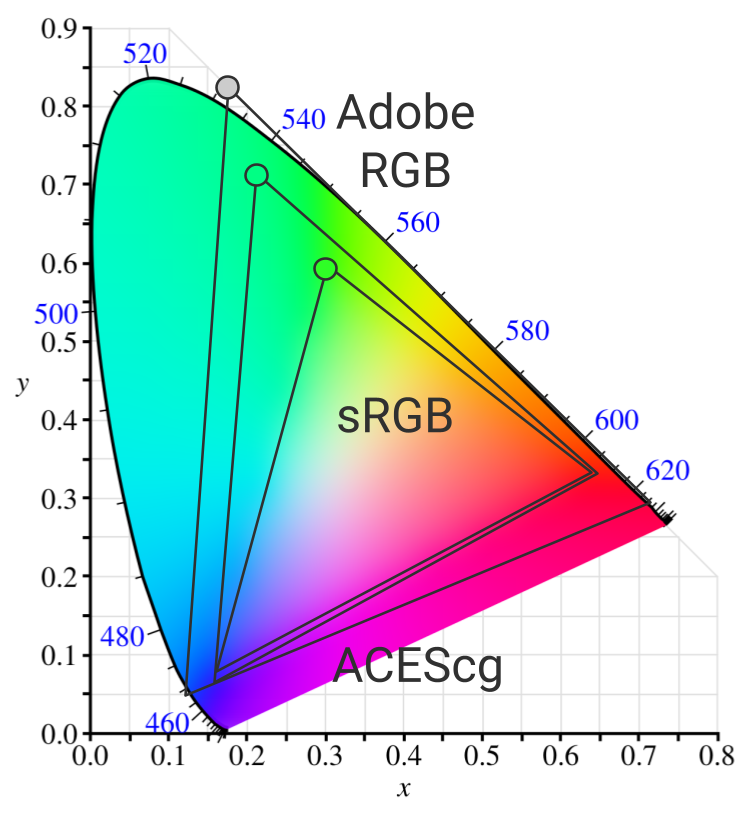

以下の画像は人間が知覚できる全ての色を模式的に図示した色度図(Chromaticity Diagram)というものです。図の外縁部の数字は単色光の波長を表していたりと、色度図には物理的な意味合いが多く含まれておりますが、ここではあくまでこのレンジの色を人間が知覚できるとご理解頂ければ幸いです。ちなみに、この色の領域や範囲のことを専門用語で色域と呼びます。

さて、人間の知覚できる色域を表したものが色度図に当たりますが「デジタルコンテンツを閲覧するときに使う映像機器は、色度図に含まれる全ての色を表現できるか?」と言われると、これはNOになります。残念ながら、現行のモニターやディスプレイでは色度図に含まれる全ての色を表現することは到底不可能なのです。では、じゃーどのようにして色を扱うかというと、映像機器でも取り扱えるように色度図の一部分を切り出して規格化したものを使います。これを専門用語で色空間(Color Space)と言います。以下で画像を交えて説明致します。

下の画像をご覧ください。色度図の中に三角形領域が三つあると思いますが、これらが色空間に該当します。色空間にも無数の種類があるのですが、ここでは代表的なものを三つだけ紹介させて頂きます。

・sRGB: 最も標準的かつ狭い色空間(小)

・AdobeRGB: Adobeが制定した色空間(中)

・ACEScg: CG制作を想定した色空間(大)

(小、中、大)の表記は色域の広さを表しておりますので、画像中では最も内側がsRGB、次にAdobeRGB、そして最も外側にあるものがACEScgに対応しております。

さて、上記の色空間を見て「なぜ色域が三角形なのだろうか?」と疑問に思われた方もいるかもしれません。それもそのはずで、何故ならそれぞれの三角形の頂点がそれぞれの色空間のRGBの原色に対応しているからです。この事実を裏返せば、色空間が変わるとRGBの原色が変化してしまうということになります。画像内に緑色のプロットがあるのが分かるかと思いますが、このように各色空間で原色のGreenをプロットしたとしても違う色になってしまうのです(ACEScgのに関してはプロットを色度図内に補正する必要があります。)。これはもちろん、画像や動画を閲覧するときに異なった色空間でデータを読み込んでしまうと意図しない色の変化が生じてしまうということにも繋がりますので十分注意する必要があります。

ここまでの説明で、色度図が何を表しているか、それからデジタルコンテンツの「色」が色空間に則って形式化されていることについてご理解頂けたかと思います。次節ではうってかわって、デジタルコンテンツの「明るさ」に関する知識や概念を紹介させて頂きます。

-明るさとガンマ補正

前節ではデジタルコンテンツの色情報に関して説明しましたが、今回は色と同じくらい重要な「明るさ」について触れます。

皆様の中に「カメラで撮った画像をパソコンで確認したら予想以上に明るかった(暗かった)」というご経験はありませんか?その問題、もしかしたらガンマ補正が悪さをしているかもしれません。

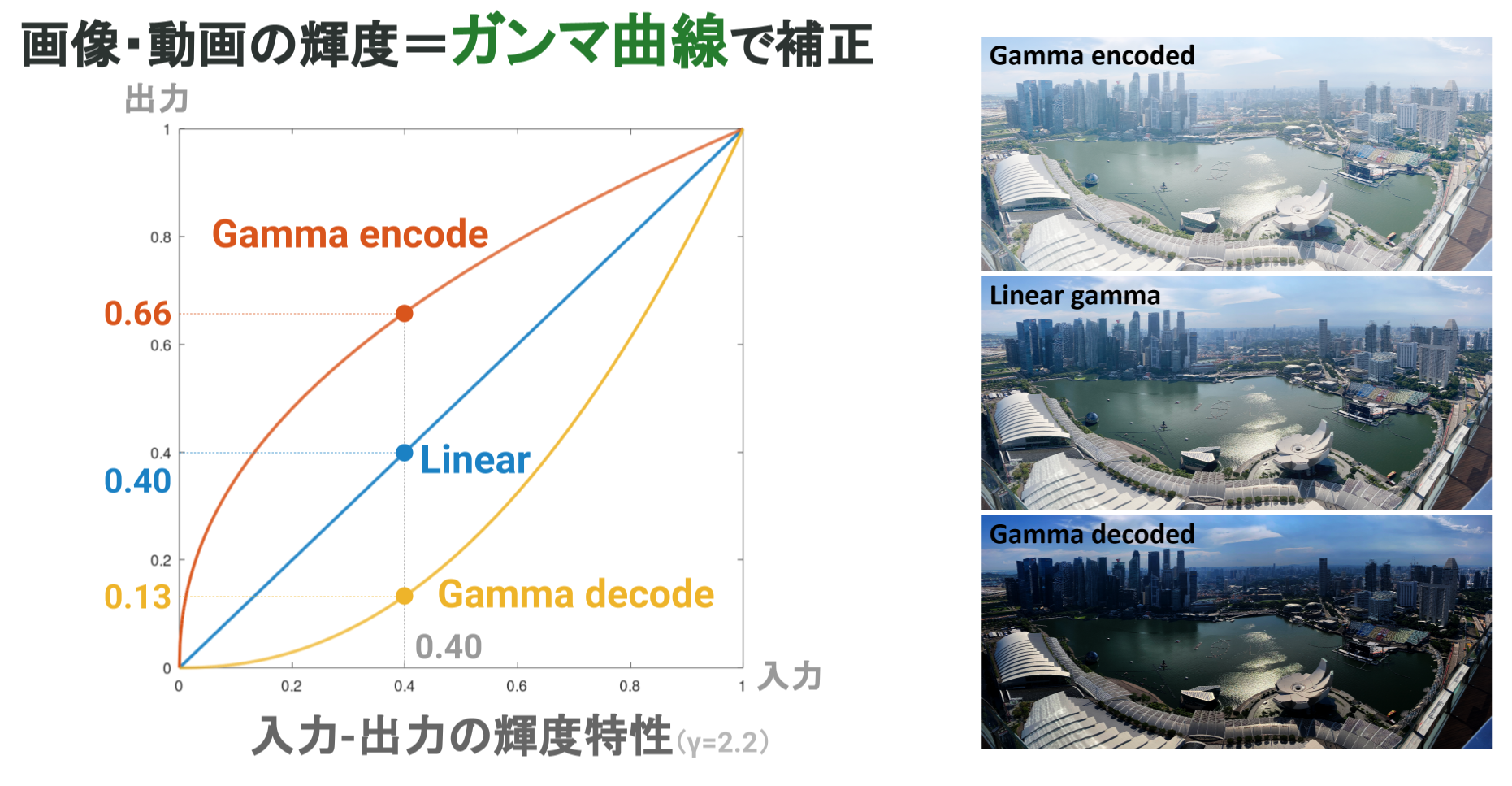

通常、画像や動画などのコンテンツはそのまま保存されることは無く、ガンマ補正が成された状態で保存されます。ガンマ補正と聞くと難しく思われるかもしれませんが、理解しなければいけないことは以下のたった3つになります。

・Gamma encode: ガンマ曲線が上に曲がっている、コンテンツを明るく補正

・Gamma decode: ガンマ曲線が下に曲がっている、コンテンツを暗く補正

・Linear gamma: ガンマ補正がかかっていない、ありのままの状態

それぞれの状態を下記の左画像にて可視化致しましたので併せてご覧ください。

技術的な背景は割愛させて頂きますが、PNGやJPEGなどの画像、MP4などの動画ファイルは、通常であればGamma encodeされた状態で保存されます。これは何故なら、モニターで映像出力する際にGamma decodeされることが大前提として認知されているからです。つまり、データ上ではencodeされているが、映像として出力する際にdecodeされるのでlinear (本来の明るさ) に戻るという原理です。

上記の右画像は、それぞれの状態で画像を出力した場合のイメージ図になります。例えば、画像自体がGamma encodeされていない(Linear gamma)状態で保存されてしまい、モニター出力の際に余分にGamma decodeされてしまった場合は、右画像3段目のような画像が表示されてしまいます。

ここまで、ガンマ補正と明るさについて説明させて頂きましたが、実用上大切なことは一つだけです。それは、モニターから出力されているコンテンツ(=自分の目に入ってくる情報)がLinear gamma状態にあることです。この点さえ気を付けていれば、少なくとも自分が見ているコンテンツは正しい明るさで表示されていると言えます。

ということで、本章では「デジタルコンテンツと「色」」と題しまして、色空間やガンマ補正について説明させて頂きました。次章では、これらの技術的知識が In-Camera VFXの撮影フローでどのように活かされているかについて説明させて頂きます。

■LEDwall Color Pipeline

-カラーマネジメント

前述しましたが、In-Camera VFXを用いた撮影は様々なデバイスを媒介とすることから、各デバイスの設定を厳密に管理することが重要になります。そして、これらデバイスの設定が前章で触れたような色空間やガンマ補正に当たります。逆を言えば、適切な設定をせずに構築されたワークフローは色味や輝度に関する一貫性を欠いたものになりますので、実用性の低いシステムとなってしまいます。以降では、色空間管理やガンマ補正を踏まえたワークフロー構築に関して説明させて頂きます。

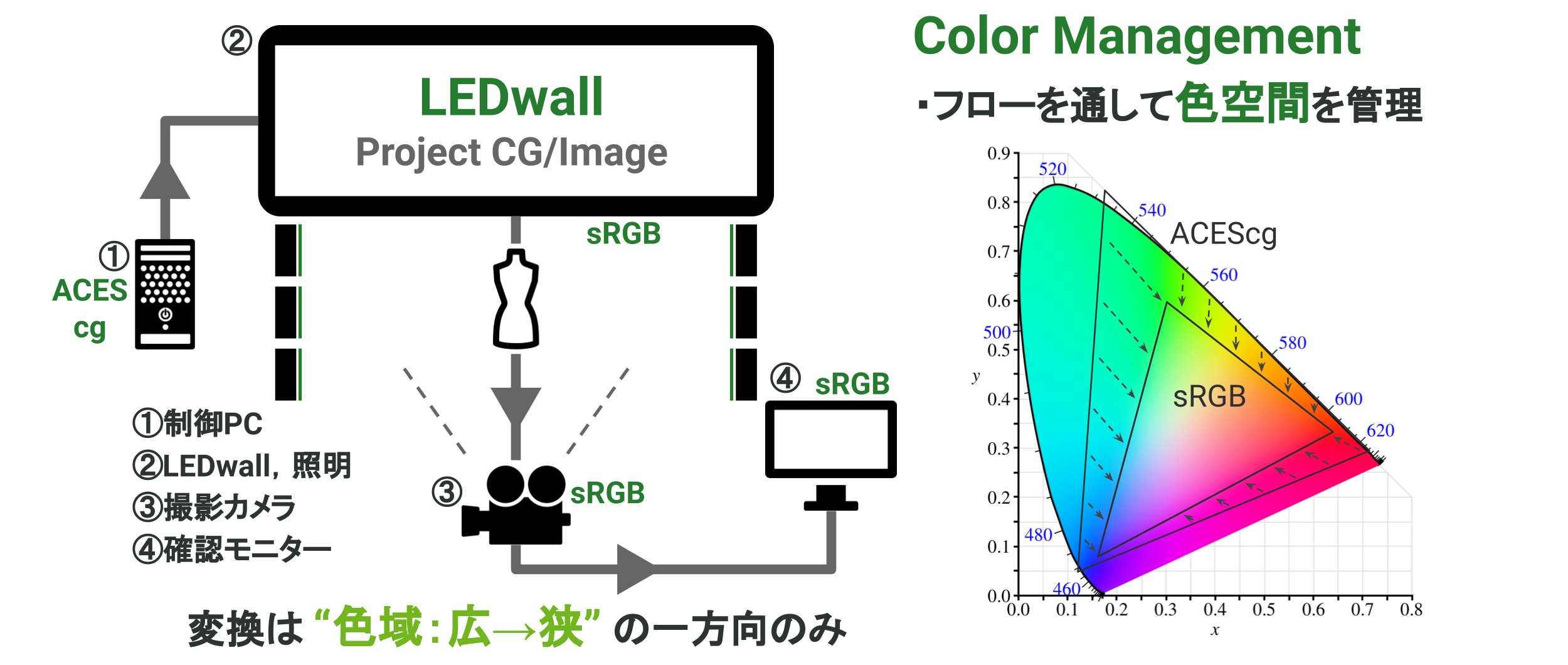

まずは色空間管理についてです。専門的な用語にはなりますが、ワークフロー上の色空間を管理することを特にカラーマネジメントと呼びます。In-Camera VFXにおけるカラーマネジメントの難しい点は、各デバイスで対応する色空間が異なる中で最適な色空間の選択を行うことにあります。例えば、最も標準的で簡単なものは、下画像のように全てsRGBで統一したワークフローになります。sRGBワークフローは演色性は低いものの、多くのデバイスが標準的にsRGBに対応していることから最も構築しやすい標準的なワークフローと言えるでしょう。

また、LEDwallにCGコンテンツを投影する場合などでは、前述したACEScgなどのより広色域な色空間から始まり、ワークフローの途中で色空間の変換を伴うケースも考えられます(下画像)。ここでの注意点としては、色空間の変換を行う場合は「色域:広→狭」への一方向のみに限定するということです。なぜなら、一般的には「色域:狭→広」の変換を行うと色情報が欠落したり大きな誤差が生じたりするからです。

上記の二つの例で挙げたように、各デバイスの色空間を適切に管理することでカラーマネジメントされたワークフローを構築することが可能です。しかしながら、実際には各デバイスで対応する色空間が異なることが多いので、システム全体の表現力を高めるような最適な色空間の遷移プロセスを考慮する必要があります。これこそがカラーマネジメントの本当の難しさとも言えるでしょう。

-リニアワークフロー

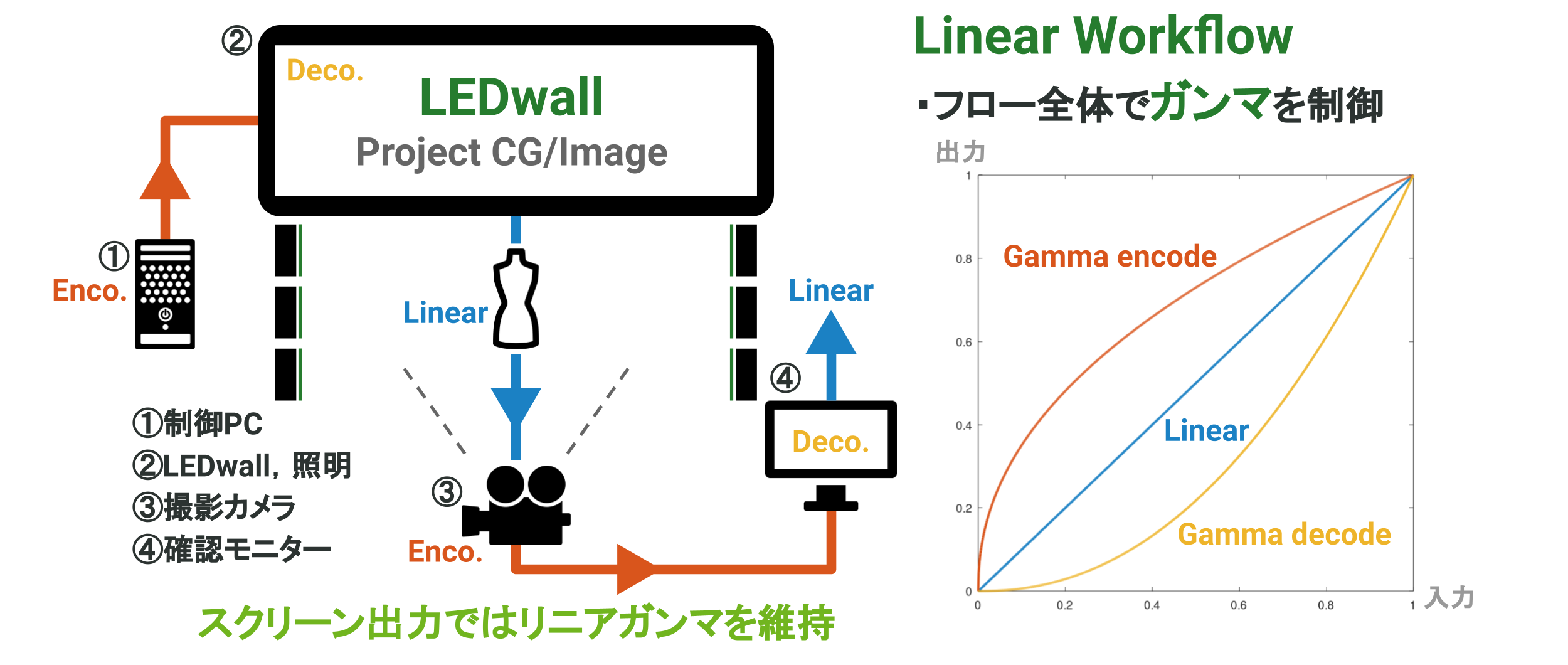

次にガンマ補正の管理についてですが、こちらは色空間管理に比べるととてもシンプルです。前述した通り肝心なことはたった一つで、スクリーン出力はLinear gammaで行うという部分になります。技術的な用語にはなりますが、このようなLinear gammaを担保したワークフローのことを特にリニアワークフローと呼びます。下記の画像を例に一つずつステップごとに説明させて頂きます。

上記画像の左にありますフローチャートで、映像情報の流れとガンマの状態を追うと、

①制御PCから送出されるデータは画像や動画なのでGamma encode状態にある。

②LEDwallが制御PCからのデータを受け、映像を出力する際にGamma decodeを行う。

そうするとLEDwall(スクリーン)からの出力はLinear gammaで行われる。

③Linear gammaのLEDwallの背景映像を、前景の被写体と一緒に撮影する。

この時、カメラ特有のGamma encodeが施された映像が送出される。

④確認モニターがカメラからデータを受け、映像を出力する際にGamma decodeを行う。

そうすると確認モニター(スクリーン)からの出力はLinear gammaとなる。

といったような流れになります。

上記に示した例のように、様々なデバイスを媒介とするIn-Camera VFXでは常に映像がどのガンマの状態にいるかを意識し、スクリーン出力の際にLinear gammaであること(リニアワークフロー)を担保する必要があります。リニアワークフローが成立しない状態では、映像の明るさが崩れてしまい白飛びや黒潰れが発生し得るだけでなく、狙い通りの映像制作をすることさえ困難となるでしょう。

本章では、色管理のためのカラーマネジメント、そして明るさ管理のためのリニアワークフローについて説明させて頂きました。実際の現場ではこれらの項目に関して十分な設計と開発を行うことで初めて、色や輝度に関して一貫性のあるワークフローを構築することができます。以下に本章の内容をまとめた画像がありますので、良ければ理解の整理にお役立てください。

■終わりに

本記事ではLEDwallを使ったIn-Camera VFXという撮影手法について説明させて頂きました。また、撮影ワークフローの構築において色や輝度に一貫性を持たせるためにカラーマネジメントやリニアワークフローの設計が必要であることも紹介させて頂きました。

サイバーエージェントでは、今後もより効率的かつ実用的な撮影スタジオ開発に取り組んで参ります。弊社にご興味のある方は是非「CyberAgent」「CyberHumanProductions」「CyberMetaverseProductions」などのキーワードで検索して頂けますと幸いです。

最後にはなりましたが、本記事をお読み頂いたことに感謝申し上げ、皆様の知識の補填や興味範囲を拡張することに繋がったのであれば大変幸いに存じます。私自身もより一層の研鑽を積んで参りますので、ご縁があれば一緒にお仕事できることを楽しみにしております!

■「CA BASE NEXT 2022」のアーカイブ動画・登壇資料は公式サイトにて公開しています。ぜひご覧ください。

https://ca-base-next.cyberagent.co.jp/2022/

■採用情報

CyberAgentでは一緒に働いて下さる仲間を募集しております!本記事で触れたような技術に関わる専門職だけでなく、CG制作全般に関わるアーティストやモデラーの方々、さらにはMachineLearningやComputerVision系の技術に精通されている研究者の方々も対象となります。

本記事を通してCyberAgentにご興味を持って頂けましたら、何卒、ご一報頂けますと幸いです。また、DigitalHumanやCG系コンテンツに特化したCyberHuman Productions、Metaverse空間上でのコンテンツ提供に注力しているCyberMetaverse Productionsも絶賛採用強化中ですので、こちらも併せてご確認頂けますと幸いです!

■著者情報

株式会社サイバーエージェント AI事業本部 AI/CG エンジニア 久家隆宏

2021年新卒入社。大学院時代は早稲田大学 応用物理学科 森島研究室にてCGレンダリングについて研究。現在は,AICG事業/CyberHuman Productionsのデジタルツインレーベルに所属し,エンジニアとしてAI・CGの両分野で研究開発に従事。

Facebook: takahiro.kuge.587

Github: Paul180297

Email: kuge_takahiro@cyberagent.co.jp